Esta teoría que comenzó a desarrollarse en la década de los 80 actualmente ya tiene un grado de madurez tal que muchos físicos la consideran como una candidata para la Teoría del Todo (Theory of Everything).

|

| Universos Paralelos como burbujas de la Inflación Cósmica |

Si este tema te resulta demasiado "físico" y te deja "botado" en algunos puntos, entonces quizás prefieras ir directamente a algunas de las notas en el siguiente índice improvisado:

- El Problema de las Constantes Físicas Fundamentales

- Principio Antrópico y Universo Finamente Sintonizado

- Teoría de las Cuerdas: Universo Multidimensional o Hiperespacio

- Problemas No Resueltos de la Cosmología

- Materia Oscura y Energía Oscura

- Expansión acelerada del Universo

- Teoría de la Inflación Cósmica y Big Bang

- ¿Por qué se rompen las Simetrías?

- Universo Holográfico: Métrica anti-de Sitter

- Huecos Negros y Paradoja de la Información

Constantes Físicas Fundamentales: Parametros de Ajuste Universales

La razón por la cual nuestro universo es tan especial, entre todos los posibles mundos del multiverso que puedan existir, es porque el conjunto de las constantes físicas fundamentales está muy finamente sintonizado para permitir no solo la aparición de nuestro sistema solar y nuestro especial planeta Tierra, con su campo magnético que nos protege de las radiaciones ionizantes como los rayos cósmicos, su radiactividad que genera su calor interior, su mecanismo activo de placas tectónicas que forman los continentes, sus océanos y su atmósfera, y todo lo que hace posible la vida biológica en toda su maravillosa diversidad (impulsada por la explosión cámbrica hace más de 500 millones de años), sino también por la existencia de la consciencia que nos da el sentido del Ser (el inefable sentido que tenemos de que Yo Existo o Yo Soy) y que, como diría un filósofo, es lo que en fin de cuentas nos permite observar el Universo que nos ha creado y llegar a conocernos a nosotros mismos.

Este conjunto de constantes físicas fundamentales, que hasta ahora se cuentan en más de veinte, funcionan como parámetros de ajuste en las múltiples teorías y modelos matemáticos de la física, y tienen nombres que recuerdan una lista de "quién es quién" en la historia de la Física, incluyendo por ejemplo: la constante de gravitación universal de Newton, la velocidad de la luz en el vacío derivada de las ecuaciones de Maxwell, la constante termodinámica de Boltzmann, la constante cuántica de Planck, el radio atómico de Bohr, la constante cosmológica de Einstein, la carga eléctrica elemental de Millikan, la masa en reposo y el spin de las partículas elementales, etc.

Así como las constantes de acoplamiento de las cuatro fuerzas físicas fundamentales (gravitación, electromagnetismo, e interacciones nucleares fuertes y débiles), la relación de jeraquía de las fuerzas (por qué la fuerza gravitatoria es tan débil comparada con la fuerza electromagnética), la relación entre la masa en reposo del protón sobre la del electrón y los parámetros de acoplamiento de leptones y quarks -- ver Modelo Estándar más adelante.

Quizás lo más asombroso de todo esto es que con solo cambiar un poco el valor de cualquiera de estas constantes físicas, nuestro universo resultaría ser muy diferente a lo que conocemos, y quizás ni siquiera podría haber llegado a crearse. Por ejemplo, si imaginamos cada universo del multiverso como una burbuja que se formó durante la Inflación Cósmica (ver más adelante sobre la linea del tiempo del Big Bang) cada una con sus propios valores de las constantes físicas, entonces en los universos donde la gravedad es muy débil, las galaxias y los planetas no podrían formarse. Aunque por otro lado si la gravedad es muy fuerte, pués entonces todas las galaxias serían huecos negros. También si la interacción nuclear fuerte no lo fuera tanto, no habría fusión nuclear y los átomos no podrian formarse. Y si la interacción nuclear débil resultara ser más fuerte de lo que es, entonces tendríamos demasiada radiactividad en el mundo lo cual sería malo para la vida biológica, etc.

Otro ejemplo un tanto dramático es que se ha calculado que si la constante de estructura fina (constante adimensional α de Sommerfeld) cambiara en un 4% solamente, entonces la fusión estelar no produciría el elemento químico carbono, lo cual haría que la vida (basada en el carbono) fuera imposible. Aún más, si dicha constante α fuera mayor que 0.1, entonces la fusión estelar en general sería imposible y ningún lugar del Universo podría ser suficientemente tibio para soportar la vida biológica como la conocemos.

Principio Antrópico: Universo Finamente Sintonizado

Este sorprendente hecho de que las Constantes Físicas Fundamentales están finamente sintonizadas para permitir la existencia de nuestro Universo, con la vida inteligente y la consciencia, es lo que los científicos llaman el Principio Antrópico de la Física (que indirectamente implica la Hipótesis Gaia de la Biología), y que algunos interpretan como un argumento teleológico, es decir, un argumento de diseño o propósito para la existencia de nuestro Universo como providenciador de la vida biológica inteligente y la consciencia.

El Principio Antrópico se puede enunciar de dos formas: a) La forma 'débil' que plantea que si las condiciones del universo fueran diferentes, nosotros posiblemente no existiríamos, es decir, que las circunstancias del universo hacen que la vida biológica sea posible pero no necesaria, o b) La forma 'fuerte' que argumenta que el universo tiene que ser como es para que nosotros podamos existir, es decir, que la circunstancias de nuestro universo hacen que la vida biológica sea inevitable (y con ella pueda emerger la consciencia en seres inteligentes como los humanos en la Tierra y quizás en otros mundos habitados también) lo cual es básicamente un argumento de diseño del Universo.

Aunque debe notarse que para los físicos en general el Principio Antrópico no es un argumento teísta, es decir, que esto no implica necesariamente la existencia de un Creador del Universo o Dios. Incluso cuando algunos físicos y filósofos utilizan el llamado 'argumento cosmológico Kalām', u otros argumentos deístas similares como la 'ley de causa y efecto', para afirmar la existencia de un Dios como Causa Primera del Universo, este Dios no sería el mismo que el dios bíblico Yahweh, ni tampoco tiene que ser un dios antropomórfico, ni siquiera tiene que ser como los dioses de otras religiones organizadas del mundo -- y en ese sentido cada físico como individuo es libre de tener su propia fe o creencia religiosa, así como sus propias opiniones o ideas metafísicas y filosóficas.

De cualquier forma que sea, el hecho que las teorías y los modelos matemáticos de la física requieran de tantas constantes o parámetros de ajuste finamente sintonizados es un problema por varias razones. Por ejemplo, el hecho que un cierto grupo de esas constantes sean fundamentales, es decir, que no puedan ser calculadas o derivadas a partir de ninguno de los Primeros Principios de la física, nos dice algo sobre las limitaciones de nuestras teorías y modelos físicos actuales.

Otra cuestión que debe ser explicada es por qué existen constantes fundamentales que son adimensionales como el caso de la constante de estructura fina alpha:

La constante α resulta ser muy especial porque relaciona tres de las más importantes constantes de la física: la carga del electón e, la constante de Planck h, y la velocidad la luz c. Esta constante se interpreta en la electrodinámica cuántica como la probabilidad de que un electrón absorba un fotón; siendo su valor igual a 1/137 (ver la Conjetura de Feynman sobre el número 137). Este curioso hecho de que existan constantes en la leyes físicas que históricamente han sido definidas o descubiertas de manera independiente, en diferentes ramas de la física, pero que luego aparecen relacionadas en una forma adimensional en las ecuaciones fundamentales de la naturaleza, es uno de los misterios que nos sugiere que posiblemente existan principios unificadores más profundos que aún no conocemos.

O incluso el hecho experimental que algunas no sean realmente 'constantes', ya que estas pueden variar en el tiempo también parece sugerir que existen otros principios y leyes más fundamentales que la física aún no conoce. Y estos son algunos de los problemas que los físicos deberían ser capaces de resolver en la medida que puedan continuar estas investigaciones fundamentales sobre el Universo.

Teoría de las Cuerdas: Universo Multidimensional o Hiperespacio

La Teoría de la Cuerdas (String Theory en inglés) asume que las partículas materiales aparentemente puntuales son en realidad estados vibracionales de un objeto más básico llamado 'cuerda'; ya sean cuerdas cerradas (topológicamente equivalentes a un círculo) o abiertas (topológicamente equivalentes a un segmento de linea recta).

Un interesante aspecto de la Teoría de las Cuerdas es que predice la existencia de un Hiperespacio con un número de dimensiones espaciales mayor que las 3D que experimentamos en nuestra realidad cotidiana. Por ejemplo, la variante llamada Teoría M (o Supercuerdas) propuesta por Edward Witten en 1995, además de unificar las cuatro interacciones físicas fundamentales en una sola teoría matemática a partir de un conjunto de primeros principios, resolver el 'problema de la jerarquía' (por qué la fuerza de la gravedad es tan débil comparada a la fuerza electromagnética y las otras fuerzas fundamentales), y predecir la existencia de todo un conjunto de nuevas partículas llamadas parejas supersimétricas (en inglés, SUSY) también predice la existencia de un total de 11 dimensiones del espacio-tiempo.

Estas dimensiones extra del espacio también son llamadas dimensiones ocultas, o 'hidden dimensions' en inglés, porque no se pueden observar directamente ya que se compactan por debajo de la Longitud de Planck de 10−35 m; como un cable de electricidad que desde lejos parece lineal pero cuando nos acercamos notamos que en realidad está formado por muchos hilos más finos.

|

| Ejemplo de Compactificación en 5 dimensiones (Teoría de Kaluza-Klein) |

La existencia de un universo de muchas dimensiones espaciales podría resultar tan maravilloso para nosotros los seres tridimensionales como lo era la tercera dimensión para los habitantes de Planilandia (Flatland en inglés). Por eso entender la física de los posibles universos multidimensionales llamados Branas (en inglés, Brane) resulta ser tan importante en la actualidad.

|

| Brana Multidimensional: Espacio de Calabi-Yau |

Problemas No Resueltos: Misterios de la Cosmología

Materia Oscura y Energía Oscura

Materia Oscura y Energía Oscura

Precisamente ese caracter multidimensional del universo podría ser la clave para explicar algunos de los misterios de la Cosmología Física, como la llamada materia oscura (dark matter, en inglés) y la energía oscura (dark energy, en inglés).

1) La Materia Oscura (dark matter) es el nombre que le fue dado a una forma desconocida de materia que tiene un rol clave en la formación de las estructuras del Universo, mantiendo las galaxias cohesionadas en sus formas espirales con igual velocidad de rotación con respecto a la distancia al centro de la galaxia, lo cual no se puede explicar solo mediante la materia visible conocida.

|

| M101: La forma de las galaxias espirales no puede ser explicada con la materia visible. |

La hipótesis de la materia oscura inicialmente surge cuando el astrofísico suizo Fritz Zwicky en 1933 aplicó el Teorema del Virial a los cúmulos de galaxias y encontró que sus formas y movimientos no se podían explicar a partir de la materia visible conocida. La razón es que la velocidad de rotación de las galaxias 'debería' disminuir con la distancia a su centro si solo existiera la materia visible conocida; pero dado que empíricamente se ha observado que la velocidad de rotación se mantiene prácticamente constante al alejarse del centro, de ahí viene la hipótesis sobre la existencia de la materia oscura.

Actualmente la materia oscura es un misterio en la física porque a pesar de constituir el 26% del total de la materia del universo, resulta ser indectectable por los actuales instrumentos astronómicos ya que no interactúa con la radiación electromagnética, tal como la luz (de ahí el nombre de 'oscura'); y por tanto solo puede ser identificada indirectamente por su influencia gravitacional en las galaxias.

2) El otro misterio en la cosmología física es el de la Energía Oscura (dark energy) que causa la expansión acelerada de nuestro universo (ver gráfica sobre el Big Bang y la linea del tiempo del universo más adelante) y que se manifiesta como una fuerza anti-gravitatoria. Y aunque el origen de la energía oscura resulta ser tan misterioso como el de la materia oscura, la hipótesis de trabajo actual es que la energía oscura es la ‘energía del espacio’ como tal. De esta forma se estima que el 95% del total de la 'masa-energía' que existe en el universo es materia oscura o energía oscura. Mientras que la 'materia normal' que puede ser observada con todos nuestros instrumentos es solo el 5% del universo.

Expansión acelerada del Universo

Ley de Hubble y Constante Cosmológica

Ley de Hubble y Constante Cosmológica

Estos misterios de la cosmología también se manifiestan en el cálculo de dos parámetros fundamentales de la cosmología y la cuestión de la expansión acelerada del unverso como se describe a continuación:

- La Constante de Hubble, que representa la velocidad de expansión del Universo, la cual se puede calcular de dos formas:

(a) Basándose en la Ley de Hubble que muestra una correlación experimental entre el corrimiento al rojo en el espectro de las supernovas con relación a su distancia. Las explosiones supernovas son eventos muy poderosos y lumisosos que ocurren en el universo cuando una estrella masiva 'muere', colapsa, explota y se convierte en una estrella de neutrones, o en un hueco negro, o se destruye completamente. La Ley de Hubble entonces establece que la velocidad de recesión de las galaxias es proporcional a su distancia; según la 'Constante de Hubble'.

La esencia de la Ley de Hubble radica en que el corrimiento al rojo en las lineas espectrales de un cuerpo celeste es una medida de la velocidad con que dicho cuerpo se aleja de nosotros; como una especie de Effecto Doppler a nivel cósmico, lo cual sugiere que el universo de alguna forma se está expandiendo -- ver más adelante sobre el Big Bang y la Teoría de la Inflación Cósmica.

Las supernovas tienen un interés especial en astronomía entre otras cosas porque sus distancias se pueden medir con bastante precisión, y por eso se utilizan para el cálculo de la velocidad de expansión del universo. Las supernovas además son importantes porque permiten la creación de los elementos químicos más pesados en el universo, a través de un proceso de Nucleosíntesis, que no se pueden producir a través la fusión nuclear en las estrellas solamente. Por ejemplo, la Nucleosíntesis en las supernovas crea los elementos silicio, hierro, níquel, y muchos más.

Las hipernovas por su parte son un caso particular de supernovas que ocurre cuando estrellas muy masivas (mayor que 30 masas solares) se colapsan al final de sus vidas en un agujero negro rotacional, emitiendo dos chorros de plasma extremadamente energéticos desde sus polos a velocidades cercanas a la de la luz. Estos chorros generan potentes rayos gamma y serían una explicación de las llamadas erupciones de rayos ramma (gamma ray bursts o GRB, en inglés), que son los eventos cósmicos más energéticos desde el Big Bang.

(b) Basándose en la Radiación de Fondo de Microondas, que es la radiación cósmica remanente del Big Bang, la cual se puede medir con gran precisión gracias a la sonda Wilkinson de la NASA (WMAP) y al satélite Planck de la ESA, apoyados por modelos cosmológicos que permiten el ajuste de esas mediciones primordiales a los tiempos actuales.

El problema es que las enormes discrepancias de cálculo sobre la expansión del universo ya están generado un profundo debate entre astrónomos y cosmólogos sobre cuán correctos (o equivocados) son nuestros modelos del Cosmos. - La Edad del Universo, que según los mejores estimados basados en la radiación de fondo de microondas se calcula en 13.8 miles de millones años, sin embargo recientemente se ha descubierto una estrella cercana a la tierra (HD 140283, conocida como Matusalén) que parece ser más vieja que el propio universo ya que su edad se calcula en 14.5 miles de millones de años, lo cual ha desconcertado a los astrónomos.

Por otro lado la existencia de parejas supersimétricas predichas por la teoría podría permitirnos avanzar en el descubrimiento de nuevas formas de energía y materia hasta ahora desconocidas por la ciencia, que van más allá del actual Modelo Estándar de la física de partículas elementales, consistente hasta ahora en 16 partículas elementales divididas en 12 fermiones (partículas de materia) y 4 clases de bosones (mediadores de los campos de fuerza) en dependencia del tipo de interacción física fundamental de que se trate, más el Bosón Escalar de Higgs (también llamado Partícula de Dios) cuyo campo genera la masa del resto de las partículas, pero que muchos físicos hoy en día consideran incompleto (ver Buscando el Neutrino Estéril para más información sobre el Modelo Estándar).

El Modelo Estándar de las partículas elementales es en esencia una Teoría de Simetrías. Técnicamente las simetrías del Modelo Estándar se basan en las propiedades matemáticas de los Grupos de Simetría de Lie del tipo SU(3) × SU(2) × U(1), y por eso el estudio de las simetrías de universo (¿cuántas existen?,¿cuándo se mantienen y cuándo se rompen?) es tan importante en la física contemponránea. Para más información sobre las simetrías en física y su relación con la layes de conservación y los campos cuánticos, ver la seccion sobre Simetría y Campos de Gauge.

|

| Modelo Estándar de las Partículas Elementales (haga click para ampliar) |

Inflación Cósmica y Big Bang: ¿Por qué se rompen las simetrías?

Las nuevas ideas mencionadas anteriormente podrían ayudar a resolver algunos problemas no resueltos de la física, como la actual teoría de la Inflación Cósmica propuesta por Alan Guth en 1981, la cual describe los instantes iniciales de la creación del universo que preceden a la expansión del Big Bang Caliente (Hot Big Bang) a través de un proceso llamado ruptura de las simetrías, donde inicialmente las interacciones fundamentales de la física (gravitación, electromagnetismo e interacciones nucleares fuertes y débiles) estaban unificadas en una única super-fuerza en un punto de singularidad, pero a medida que disminuyó la temperatura del universo, estas simetrías comenzaron a romperse produciendo las partículas e interacciones que tenemos hoy.

En cuanto a otros nombres de teorías de unificación relacionadas con la Inflación Cósmica debe señalarse que la teoría que unifica las interacciones del Modelo Estándar en una sola fuerza para altas energías se llama GUT (Grand Unified Theory, en inglés) mientras que a la teoría que unifica la GUT con el espacio-tiempo y la Gravitación se le llamaría TOE (Theory of Everything, en inglés) -- Los físicos modernos suelen mostrar su sentido del humor en los nombres de sus teorías, ya que por ejemplo GUT significa 'intestino' y TOE es 'dedo del pie'; y también tenemos los QUARKS que es más un fonema que una palabra reconocida del inglés y quién sabe lo que significa eso :-).

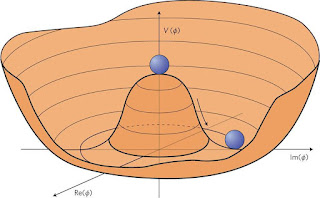

El concepto de ruptura de las simetrías resulta ser muy importante en la física contemporánea y se entiende como un fenómeno donde una pequeña fluctuación, al actuar sobre un sistema que pasa por un punto crítico, produce una transición (como un cambio de fase a nivel cuántico) que determina el destino de dicho sistema. Sin embargo para un observador externo estas fluctuaciones pueden parecer aleatorias; como si fuera 'ruido en el sistema'. La ruptura de las simetrías también resulta importante en la formación de patrones en el mundo natural.

Matemáticamente la ruptura espontánea de la simetría se demuestra cuando un sistema físico descrito con el formalismo Lagrangiano tiene ciertas simetrías, pero el nivel de energía básico (la solución en el vacío) no contiene las mismas simetrías. Entonces, cuando dicho sistema pasa por el estado básico, la simetría se rompe debido a las perturbaciones (fluctuaciones) del vacío, sin embargo el Lagrangiano retiene las simetrías para niveles superiores de energía -- Ver Nota sobre Simetrías en la Física para más información sobre estas teorías.

|

| Partículas virtuales generadas por las fluctuaciones del vacío |

Otra forma de ver este evento de 'singularidad cósmica' durante el cual ocurre la ruptura de simetrías GUT es mediante el siguiente gráfico que muestra como la materia se separó del espacio-tiempo, y la energía liberada en el proceso se utilizó para crear las partículas elementales.

La teoría de la Inflación Cósmica resuelve el Problema del Horizonte o por qué la temperatura del universo resulta ser tan uniforme (homogenea e isótropa) y explica por qué el espacio-tiempo es topológicamente plano. Otro aspecto atractivo de la teoría de la Inflación Cósmica es que no require la hipótesis de la 'singularidad inicial' del Big Bang. Aunque por otro lado se supone una expansión inicial a velocidades superlumínicas, es decir, que la actual velocidad de la luz en el vacío no habría sido un límite en aquel momento ya que los fotones aún no existían (la radiación térmica se propagó más rápido que la gravedad) la cual es una hipótesis que pronto se espera poder probar en los experimentos del LIGO que buscan detectar las ondas gravitacionales y otros experimentos.

|

| Linea de Tiempo de Nuestro Universo (Inflación Cósmica + Big Bang) |

Universo Holográfico: Espacio anti-de Sitter (adS)

Quizás también estas ideas permitan confirmar la teoría alternativa llamada Universo Holográfico, la cual es una idea o un Principio Matemático propuesto por Gerard Hooft, Leonard Susskind, Juan Maldacena y otros en los años 90, que establece que la información de nuestra realidad 3D está codificada como si fuera un holograma en una superficie 2D en la frontera, lo cual pronto se espera poder comprobar empíricamente. Estas nuevas ideas sobre el espacio-tiempo se basan en las propiedades matemáticas del llamado Espacio anti-de Sitter (adS), donde se ha encontrado que las ecuaciones matemáticas que describen la gravitación (la geometría del espacio-tiempo) son equivalentes a la matemática de la física cuántica pero con una dimensión menos. Lo cual nos hace recordar las propiedades de un holograma, cuya superficie bidimensional plana puede codificar una imagen tridimensional.

Los físicos llaman "dualidades" a ciertas parejas de teorías matemáticas, desarrolladas a partir de Primeros Principios diferentes, pero que no obstante pueden proveer una descripción equivalente de ciertos fenómenos físicos, como los fenómenos cuánticos y la gravitación. Como si fueran dos enfoques o prespectivas aparentemente muy diferentes, pero que de alguna manera son equivalentes porque en el fondo se refieren a un mismo "objeto". Lo cual sugiere que tal vez exista algún principio unificador que aún no se ha descubierto, y por eso estas dualidades son de tanto interés en la física teórica.

Tal es el caso de la Dualidad adS/CFT, donde adS se refiere a la geometría del espacio "anti-de Sitter", y CFT se refiere a la "Conformal Field Theory" que es la teoría matemática que lo sostiene. La idea física detrás de la dualidad adS/CFT es que el espacio-tiempo, y todo lo que hay en él, emerge como un holograma a partir de la información almacenada en los estados cuánticos entrelazados de las partículas. O como famosamente dijera el célebre físico americano John Archibald Wheeler: "it from bit".

Estos principios además podrían resolver el problema de los 'agujeros de gusano' o 'Puente ER' (en inglés, wormholes o Einstein–Rosen bridge) y la paradoja de la información en los 'huecos negros' -- ver nota al final.

Para conocer más sobre estas fascinantes teorías físicas y sobre los científicos que actualmente trabajan en ellas recomendamos el documental titulado Parallel Universes de BBC Horizon (en inglés) que explica estas ideas en un lenguaje sencillo y fácil de entender.

Si las predicciones de estas novedosas teorías físicas pueden comprobarse empíricamente, ya sea en observaciones cosmológicas como la radiación de fondo de microondas remanente del Big Bang y en los huecos negros, o en experimentos de laboratorio como los realizados en el Fermilab o los que se esperan realizar en el Large Hadron Collider (LHC) en el CERN, quizás en verdad, como ha dicho el célebre físico Stephen Hawking, los seres humanos en la tierra pronto llegaremos a conocer "la mente de Dios".

Huecos Negros y Paradoja de la Información

Entender la física de los huecos negros es muy importante en la actualidad ya que estos sirven como una especie de laboratorio cósmico natural donde los físicos pueden probar sus teorías fundamentales sobre la naturaleza, incluyendo la mecánica cuántica y la gravitación.

La paradoja de la información es una contradicción en la actual teoría de los huecos negros que parece implicar que la información puede ser destruída dentro del agujero negro, lo cual no debería ser físicamente posible según algunos bien establecidos teoremas de la mecánica cuántica (como el Teorema de Liouville) que demuestran que la información nunca puede ser destruída (aunque sí puede ser "scrambled" o revuelta, siempre que sea posible reconstruirla al menos en principio). Este es un principio fundamental de la física denominado "Unitariedad" (Unitarity, en inglés), que es una forma sofisticada de decir que la suma de las probabilidades de todos los posibles eventos siempre tiene que ser igual a la Unidad, es decir, el valor 1 de la probabilidad total, lo cual permite nuestra capacidad de rastrear la historia física del universo; al menos en principio.

No obstante, los físicos esperan que la paradoja de la información pueda ser resuelta mediante nuevas teorías o principios como la Conjetura ER=EPR, o las propiedades del espacio anti-de Sitter (adS) mencionado anteriormente, y otras novedosas ideas -- para más información véase la siguiente linea de tiempo en detalle.

Historia: Linea de Tiempo

La historia de los Huecos Negros con la Paradoja de la Información es un buen ejemplo de cómo avanza la física contemporánea, gracias al trabajo de muchos notables investigadores apoyados por varias instituciones y gobiernos, rigurosamente aplicando el método científico. He aquí un resumen de los poco más de 100 años de historia del tema:

1916 - La Teoría General de la Relatividad de Einstein (Teoría del Campo Gravitatorio) establece el fundamento matemático para la existencia de los huecos negros. En ese mismo año Karl Schwarzschild resuelve las ecuaciones del campo gravitatorio por primera vez y demuestra que el radio de un hueco negro estático es proporcional a su masa -- más tarde Alexander Friedmann y Georges Lemaître también resuelven las ecuaciones para el caso de un universo en expansión, y Roy Kerr resolvió las ecuaciones para un hueco negro que rota. El conjunto de estas soluciones constituye el llamado 'Modelo Estándar de la Cosmología'.

A la solución del hueco negro estático se le llama 'Métrica de Schwarzschild' y a la fórmula del radio del hueco negro estático se le llama 'Radio de Schwarzschild'. Nada puede salir de un hueco negro, ni siquiera los fotones de la luz; de ahí su nombre.

La razón física es que el fotón tiene una energía proporcional a su frecuencia (E = hf) y por tanto también tiene una masa relativista según la relacion masa-energía (E = mc2); lo cual significa que va a ser atraído (y mantenido dentro) por la gran masa de hueco negro.

Solo como ilustración matemática, el Radio de Schwarzschild (R) de un hueco negro de masa M se puede calcular a partir de la fórmula de la Velocidad de Escape, o sea, la velocidad minima con la que debe lanzarse un cuerpo para que escape de la atracción gravitatoria de la Tierra o de cualquier otro planeta, la cual se alcanza cuando la energía cinética del cuerpo es igual en magnitud a la energía potencial gravitatoria. Por ejemplo, para un objecto lanzado desde la superficie de la Tierra, la velocidad de escape es de 11.2 km/s. En general, la fórmula para la Velocidad de Escape (Ve) de un astro de masa M y radio R es:

Ve = √ 2GM / R

Entonces, suponiendo que la velocidad del fotón es la de la luz en el vacío (c) y haciendo un poco de álgebra se puede demostrar que el radio R del hueco negro depende solo de su masa M según la relación:

R = 2GM / c2

El Radio de Schwarzschild (R) es esencialmente una relación masa-radio para los huecos negros, donde la constante de proporcionalidad depende de G, la Constante de Gravitación Universal de Newton, y de c, la velocidad de la luz en el vacío.

La interpretación física de todo esto es que un hueco negro 'nace' cuando una estrella masiva 'muere' en una explosión supernova y su masa residual M colapsa en una esfera de radio R por efecto de la gravedad; según la relación anterior. El corolario de esto es que cuando un cuerpo cae en el hueco negro, toda su información permanece segura dentro de él.

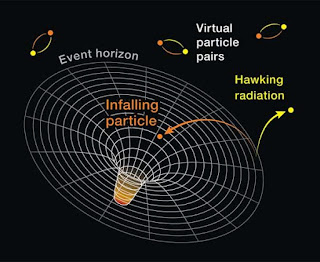

1928 - Paul A. M. Dirac deriva la ecuación de onda relativista de la Mecánica Cuántica que predice las partículas virtuales que se generan por el efecto cuántico-relativista de las fluctuaciones del vacío y que son fundamentales en la teoría cuántica de campo. Según Dirac, el vacío físico sería como un mar de partículas con energía negativa, de forma tal que cuando en el vacío ocurren fluctuaciones (según la Relación de Incertidumbre de Heisenberg entre Energía y Tiempo ΔE * ΔT ≥ ℏ/2) eso causa la aparición de parejas de partículas y antipartículas (como por ejemplo parejas de electrón-positrón) durante un breve tiempo; y por eso se llaman 'partículas virtuales'.

1958 - David Finkelstein se basa en la solución de Schwarzschild de las ecuaciones del campo gravitatorio (Radio de Schwarzschild) para definir el Event Horizon (Horizonte de Sucesos) como "una membrana perfectamente unidireccional donde las influencias causales solo pueden cruzar en una dirección". A partir de ahí el Event Horizon es identificado como la frontera del hueco negro. Mientras que el centro del hueco negro es considerado un punto de Singularidad donde la densidad es infinita y el espacio-tiempo se curva infinitamente, causando que la leyes de la física dejen de operar tal y como las conocemos.

1960 - 1972 - La 'era dorada' en el estudio de huecos negros con significativos avances teóricos, como por ejemplo:

1) El Teorema de No-Pelo ('no-hair', en inglés) propuesto por el singular físico teórico americano John Wheeler (1960), quien por cierto acuñó oficialmente el término 'black hole' durante una conferencia en la NASA (aunque el término ya había sido usado por otros anteriormente), diciendo que: "Los huecos negros no tienen pelo". Lo cual significa que en principio son objetos simples caracterizados por 3 parametros solamente: masa, momentum angular y carga eléctrica. Esta conjetura además establece que ni siquiera el material que es "tragado" por el hueco negro puede alterar estos parámetros primarios. Aunque hoy en día una de las ideas que se están explorando es que, contrario a lo planteó Wheeler en el 'teorema de no pelo', en realidad los huecos negros podrían tener "pelos cuánticos", por así decirlo, y eso podría explicar la paradoja de la información.

2) El Teorema de la Singularidad del físico-matemático Roger Penrose (1965) que demuestra matemáticamente como el proceso de creación de los huecos negros es un proceso 'estable' y como la llamada Singularidad en el centro del hueco negro, donde las leyes de la física no aplican, es una consecuencia inevitable de la Teoría General de la Relatividad. De esta forma también se explica la relación entre los Quasars (quasi-stellar object) y los Huecos Negros; ya que los cuásares son fenómenos que surgen cuando un enorme agujero negro, en el núcleo de una galaxia, comienza a atraer la materia en su cercanía, y por efecto de la enorme velocidad de rotación del disco de acreción formado, se produce una gigantesca cantidad de energía, liberada en forma de ondas de radio, luz, infrarrojo, ultravioleta y rayos X, lo que convierte a los cuásares en los objetos más brillantes del universo conocido. Penrose además demuestra que es posible extraer energía de un hueco negro rotacional hasta que se convierte en un hueco negro estático. Este es el llamado 'Proceso de Penrose'.

3) El Teorema de la Entropia de los huecos negros de Jacob Bekenstein (1972). La entropía en este caso se interpreta como una medida de la cantidad de información que se pierde cuando la materia es tragada por el hueco negro. El teorema de la entropía demuestra que la Entropía S (Información) en un hueco negro depende solo del area (A) de su Event Horizon (no de su volúmen), lo cual luego condujo al Principio Holográfico (como si toda la información dentro de un hueco negro estuviera codificada como un 'holograma' en su frontera), según la elegante fórmula que incluye varias de las más famosas constantes universales:

Donde lp es la Longitud de Planck: , cuyo valor es del orden de 10−35 m.

La otra implicación de la fórmula de la entropía es que los huecos negros solo pueden crecer más (la entropía solo puede crecer, no disminuir), es decir que los huecos negros nunca pueden hacerse más pequeños, tragándose información a medida que crecen; amenazando así nuestra capacidad de rastrear la historia física del universo.

4) El comienzo de importantes avances experimentales como la creación del LIGO (Laser Interferometer Gravitational-Wave Observatory) y el Event Horizon Telescope (EHT) consistente en una red global de raiotelescopios que permiten observar los huecos negros supermasivos y las ondas gravitacionales.

1974 - 1976 - Stephen Hawking utiliza la Mecánica Cuántica relativista para demostrar matemáticamente que los huecos negros no son realmente negros, ya que emiten un tipo de radiación de fotones (llamada Radiación de Hawking) lo cual causa que los huecos negros se evaporen con el tiempo; hasta que eventualmente desaparecen o 'mueren'. La Radiación de Hawking tendría una composición espectral similar a la radiación de un cuerpo negro a una cierta temperatura T en la termodinámica clásica, según la siguiente fórmula:

Pero en realidad la radiación de Hawking es causada por las fluctuaciones cuánticas del vacío en el Event Horizon. El problema es que eso implicaría que la información dentro del hueco negro desaparece. En otras palabras, que si bien los huecos negros pueden tragarse otros cuerpos que tenían información bien organizada y codificada, por otro lados ellos solo nos pueden devolver una radición térmica aleatoria 'no codificada', es decir, que la información se perdió dentro del hueco negro. Los físicos están atónitos.

1990 - Leonard Susskind y Juan Malcadena proponen la Complementariedad que temporariamente resuelve el problema. La información no se pierde porque a la vez que pasa por el Event Horizon también se refleja en él de manera complementaria.

1997 - La paradoja sobre la información en los huecos negros (si se pierde o no) motivó una apuesta pública entre tres de lo más notables físicos que estudiaban los huecos negros; Stephen Hawking, Kip Thorne y John Preskill (conocida como la apuesta de Thorne–Hawking–Preskill). En el 2004, luego que Malcadena y Susskind matemáticamente demostraron que los huecos negros preservan la información, Hawking concedió la puesta diciendo que él ahora creía que el Event Horizon de los huecos negros debería fluctuar y filtrar la información.

2004 - Hawking acepta la teoría de Malcadena y Susskind de que los huecos negros preservan la información. La Teoría General de la Relatividad y la Mecánica Cuántica están a salvo, ambas; al menos por el momento.

2012 - Joseph Polchinski y otros dicen que la Complementariedad viola las reglas del Entanglement (Entrelazamiento Cuántico) y proponen que debe existir un Firewall (pared de fuego) en el Event Horizon debido a la ruptura del entanglement. La información se preserva y se puede recuperar, pero el problema es que la proposición del Firewall viola el Principio de Equivalencia de la Teoría General de la Relatividad; que plantea que si un desafortunado observador cae en el hueco negro, dicho observador local no podría saber exactamente cuando cruza el Event Horizon.

Los físicos utilizan el término "espagetizado" para referirse a lo que le pasa a un objecto que cae en el hueco negro; el cual sería un proceso contínuo de dilatación del espacio-tiempo a medida que el objecto cruza el Event Horizon. Por otro lado, el Firewall no sería un proceso contínuo, sino que, utlizando la misma metáfora culinaria, el objecto sería "asado" por la radiación del hueco negro en el Event Horizon; en lugar de ser "espagetizado". Y esa es la diferencia entre las dos teorías actuales sobre los huecos negros.

|

| Paradoja de la Información: Complementariedad vs Firewall |

2014 - Nuevas soluciones se proponen, incluyendo los 'wormholes' con opción de 'teleportation', o la 'Conjetura ER=EPR' que establece que dos partículas entrelazadas (un par EPR o Einstein-Podolsky-Rosen) están conectadas por un agujero de gusano (ER o puente Einstein-Rosen), etc. Las nuevas teorías no han podido ser comprobadas experimentalmente aún.

2019 - ¡La primera imagen de un hueco negro! La imagen capturada corresponde a un hueco negro supermasivo en el centro de M87, una galaxia elíptica gigante en la constelación Virgo.

|

| La primera imagen de un hueco negro (M87) mostrando el Event Horizon |

2020 - Roger Penrose, Reinhard Genzel y Andrea Ghez, reciben el premio Nobel de Física por sus trabajos sobre los huecos negros. Penrose por su teoría que matemáticamente demuestra como los huecos negros se derivan naturalmente de la Teoría General de la Relatividad, mientras que Genzel y Ghez lo reciben por el descubrimiento experimental del hueco negro supermasivo que existe en el centro de nuestra galaxia; la Vía Láctea.

Nota sobre los premios Nobel de física: Algunos se preguntan por qué a Stephen Hawking no se le otorgó el premio Nobel de Física por la Teoría de los Huecos Negros, junto a Roger Penrose, en el 2020. Una de las razones es que Hawking falleció en el 2018 y el comité Nobel no otorga premios póstumos. Además el comité Nobel tiene otras reglas muy particulares respecto a sus premios, como que no pueden ser otorgados a más de tres personas. La otra regla no escrita es que el comité Nobel prefiere los resultados experimentales sobre los teóricos, y la predicción de la 'radiación de Hawking' aun no se ha podido comprobar experimentalmente.

Incidentalmente esa es la razón por la cual Einstein recibió el premio Nobel de física en 1921 por el Efecto Fotoeléctrico, pero no por la Teoría de la Relatividad que fue su mayor aporte. Es decir, que no se otorgan premios Nobel de física a teorías físicas puras, por muy matemáticamente rigurosas que sean y por muy explicativas que puedan ser, hasta que no se hayan comprobado experimentalmente.

Al menos esa ha sido la tradición del comité Nobel de física hasta ahora; aunque tal vez esa tradición está cambiando y últimamente el comité Nobel parece más inclinado a otorgar premios a teorías un tanto más especulativas y debatibles, que además parecen tener implicaciones sociales y políticas, como el premio otorgado en el 2021 a tres investigadores por sus aportes al entendimiento de los sistemas complejos, incluyendo los "modelos climáticos" y el "calentamiento global".

Notas (Documentales en Youtube):

BBC Horizon: Parallel Universes (trailer)

BBC Universe: Multiverse (Discovery Channel)

Transcripción del programa:

http://www.bbc.co.uk/science/horizon/2001/paralleluni.shtml

BBC Horizon: Parallel Universes (trailer)

BBC Universe: Multiverse (Discovery Channel)

Transcripción del programa:

http://www.bbc.co.uk/science/horizon/2001/paralleluni.shtml

, cuyo valor es del orden de 10−35 m.

, cuyo valor es del orden de 10−35 m.