- Buscando el Neutrino Estéril

- Introducción al Modelo Estándar y la Teoría Cuántica de Campos

- El Modelo Estándar de las Partículas Elementales

- Las Cuatro Fuerzas Fundamentales de la Naturaleza

- Fuerzas de Intercambio: Fermiones y Bosones

- Espín: El número cuántico más importante

- Fermiones: Quarks y Leptones

- Bosones: Fotones, Gluones, W y Z

- Antimateria: Partículas y Antipartículas

- Buscando el Bosón de Higgs: La Partícula de Dios

- Masa en Reposo de las Partículas: Tres Generaciones

- Teorías de Simetría: ¿Por qué Modelo y no Teoría?

- Problemas No Resueltos del Modelo Estándar

- Violación de la Paridad y Simetría CPT

- Misterios de la Cosmología Fisica: Posibles Soluciones

- Partículas y Cuasipartículas (Aplicaciones)

- Semiconductores (Electrones y Huecos)

- Transistores (Contacto, Juntura, FET, etc.)

- Superconductividad (Pares de Cooper)

- Condensado Bose-Einstein (BEC) y Condensado Fermiónico

- Otras Cuasipartículas

- Apéndice: Teoría Cuántica de Campos (QFT)

- Cuantización del Campo en la QFT

- Vacío Cuántico y Energía del Punto Cero

- Diagramas de Feynman y Partículas Virtuales (QED)

- La Magia de la Renormalización

- Importancia de las Simetrías en Física

- Relación entre Simetrías y Leyes de Conservación

- Simetría de Gauge (Invarianza de Calibración)

- Grupos de Simetría de Lie: Grupos SU(n) en la QFT

- Formalismo Lagrangiano

- Electrodinámica Cuántica (QED) y Cromodinámica Cuántica (QCD)

- Teoría de Campos de Gauge de Yang-Mills

- Alcance de la Teoría de Yang-Mills

- Notas: El Experimento Muon g-2

Buscando el Neutrino Estéril

Los neutrinos son considerados las 'partículas fantasma' de la naturaleza por lo elusiva que resulta su detección en experimentos de laboratorio como los del Fermilab or el LHC, o incluso en observaciones cosmológicas, como las que se realizan en la Antártida para medir los rayos cósmicos utilizando el detector IceCube (enterrado a una milla bajo el hielo) y en el Telescopio de Neutrinos (KM3NeT) enterrado en el fondo del mar Mediterráneo, ya que interactúan muy poco con la materia ordinaria.

Como acostumbramos a hacer en este blog, empezaremos con una breve historia. Durante muchos años, en los experimentos de radioactividad se detectaban protones y neutrones (núcleo de helio en la desintegración alfa) junto al electrón emitido (desintegración beta) y los fotones de alta energía (desintegración gamma), pero faltaba algo. El problema era que en física hay dos cantidades que siempre se conservan; la energia total y el momentum-impulso o 'cantidad de movimiento' (definido como el producto de la masa por la velocidad). Estas 'leyes de conservación' normalmente se pueden enunciar de la siguiente forma:

1. Ley de Conservación de la Energía: La suma de las energías de las partículas debe tener el mismo valor antes y después de un evento.

2. Ley de Conservación del Momentum (Impulso): El impulso total de las partículas iniciales debe ser igual al impulso total de las partículas finales.

Pero de alguna manera para estas desintegraciones beta siempre faltaba algo; no se conservaban ni la energía ni el impulso.

Los físicos estaban atónitos; algunos incluso llegaron a creer que la conservación de la energía y el momentum no eran leyes generales de la física. Sin embrago el físico Wolfgang Pauli tenía una idea diferente y radical: tal vez había un nuevo tipo de partícula emitida en estas desintegraciones, una que simplemente todavía no teníamos la capacidad de ver. Luego Enrico Fermi lo llamó "neutrino", que en italiano significa "pequeño neutro". Al plantear su hipótesis, Pauli famosamente comentó sobre la herejía que había cometido: "He hecho algo terrible, he postulado una partícula que no se puede detectar".

Según la teoría de Pauli, había una nueva clase de partículas que se emitían en determinadas reacciones nucleares. Cuando un neutrón se desintegra en un protón y un electrón, también debe crear un neutrino del tipo 'anti-electrón', conservando el número leptónico (el número total de leptones menos el número total de antileptones) así como el número de la 'familia' de leptones (electrones, muones y tau). Propuesta en 1930, la teoría de Pauli fue reivindicada en 1956, cuando se detectó el primer (anti) neutrino en reactores nucleares.

Otro misterio sobre los neutrinos es su masa en reposo y su velocidad. Inicialmente se supuso que los neutrinos tenían masa en reposo nula, lo cual les permitiría moverse a la velocidad de la luz en el vacío. Sin embargo algunos resultados experimentales indicaron que los neutrinos tenían cierta masa en reposo, que aunque muy pequeña, hacía que se movieran a una velocidad cercana pero menor a la de la luz en el vacío. Pero entonces, sorpresivamente, un experimento llamado OPERA que se realizó en el CERN reportó que los neutrinos se estarían moviendo a una velocidad mayor que la de la luz, lo cual desconcertó a los físicos ya que esto violaría la bien establecida Teoría de la Relatividad de Einstein. Sin embargo, un experimento posterior en el propio CERN, llamado ICARUS, pudo medir la velocidad de los neutrinos con más precisión que la de OPERA, y reportó que los neutrinos en realidad se mueven a una velocidad cercana a la de la luz, pero menor, confirmando una vez más uno de los postulados fundamentales de la Teoría de la Relatividad.

Hoy en día los neutrinos continúan siendo objeto de intensa investigación científica dada sus extrañas propiedades y su relación con el resto de las partículas elementales del Modelo Estándar como se verá a continuación.

El Neutrino Estéril (o Inerte) sería una nueva clase de neutrino que solo interactúa a través del campo gravitatorio al tener una masa no-nula (y no a través de las interacciones conocidas en el Modelo Estándar donde los neutrinos activos deberían tener masa nula) y que según la Teoría de las Cuerdas podría entrar y salir de las extra dimensiones espaciales produciendo el fenómeno experimental conocido como oscilación de neutrinos; en el cual los neutrinos se transforman en los tres tipos de neutrinos conocidos siguiendo un patrón repetitivo.

|

| Detector de Neutrinos en el Fermilab |

Para poder encontrar al neutrino estéril en el laboratorio subterráneo del Fermilab han construído el detector ArgoNeuT (mostrado en la foto) que pronto dará paso al tanque criogénico con 170 toneladas de argón líquido llamado MicroBooNE, el cual a un costo de $15 millones USD se espera entre en operaciones en el 2011, y quién sabe, tal vez con esta nueva tecnología los físicos pronto encuentren las extra dimensiones del espacio y hasta los universos paralelos teorizados por la mecánica cuántica.

|

| Instalando el MicroBooNE |

Modelo Estándar y Teoría Cuántica de Campos (QFT): Introducción

El Modelo Estándar de las partículas elementales (Standard Model o SM para abreviar en inglés) es la joya de la corona de la física contemporánea y un gran logro de la ciencia, ya que una vez completado logró poner orden en lo que los físicos llamaban el "zoológico" de las partículas elementales, con docenas de partículas que hasta ese momento se habían descubierto sin relación aparente entre ellas.

Pero también es un tema muy amplio y complejo desde el punto de vista matemático, con una larga historia, ya que se fundamenta en el Modelo Lagrangiano de la Teoría Cuántica de Campos (QFT: Quantum Field Theory, en inglés), que incluye la Electrodinámica Cuántica (QED: Quantum Electrodynamics, en ingles), la Cromodinámica Cuántica (QCD: Quantum Chromodynamics, en inglés), la Teoría de los Campos de Gauge de Yang-Mills (Yang–Mills Theory), los Grupos de Simetría que a su vez se relacionan con Leyes de Conservación en física, los Diagramas de Feynman y las Técnicas de Renormalización necesarias para evitar la divergencia de las soluciones para altas energías, etc. -- ver Apéndice sobre la Teoría Cuántica de Campos (QFT).

Esta confluencia de múltiples técnicas matemáticas es la razón por la que muchos la consideran la rama más compleja de la física desde el punto de vista matemático. Aunque también es la rama de la física contemporánea que más éxito empírico ha tenido, tanto en su comprobación en experimentos de laboratorio como en observaciones cósmicas; a pesar de los problemas que aún quedan por resolver.

No obstante, como acostumbramos hacer en este blog, de todas formas hemos querido escribir algunas notas sobre el tema, enfatizando las nuevas ideas y los conceptos físicos básicos que cualquiera puede entender, sin tener que entrar en las complejidades matemáticas que manejan los expertos.

Modelo Estándar de la Física de Partículas Elementales

12 Fermiones y 4 Bosones

12 Fermiones y 4 Bosones

El Modelo Estándar (Standard Model o SM, en inglés) de la física de partículas elementales -- completado en 1973 -- consiste hasta ahora en 16 partículas elementales (o 17 si se incluye el Bosón de Higgs en el Modelo), divididas en 12 Fermiones (partículas de materia con espín 1/2) y 4 clases de Bosones (mediadores de los campos de fuerza con valor de espín entero) en dependencia del tipo de interacción física fundamental de que se trate. ¿Pero de dónde vienen estas ideas? Veamos.

Las Cuatro Fuerzas Fundamentales de la Naturaleza

Desde hace ya mucho tiempo los físicos habían descubierto que en la Naturaleza solo existen cuatro fuerzas fundamentales: la fuerza gravitatoria, la fuerza electromagnética, y las dos interacciones nucleares (originadas en el núcleo atómico) y que simplemente se llaman fuertes y débiles:

(1) La fuerza gravitacional es la fuerza que mantiene a todos los objetos con masa atraídos entre sí, esencialmente manteniendo a los planetas en órbita alrededor de las estrellas e incluso influyendo en la formación de galaxias y otros cúmulos de materia a escala cósmica; sin la gravedad, no podríamos permanecer en la Tierra, y el universo tal como lo conocemos no existiría.

(2) La fuerza electromagnética es crucial para la vida cotidiana porque es responsable de mantener unidos los átomos, formar moléculas, irradiar luz, producir electricidad y magnetismo, crear la fricción que nos permite caminar, y, esencialmente, sustentar la mayoría de los fenómenos químicos y físicos que experimentamos en la vida cotidiana; sin ella, la materia y la vida biológica tal como la conocemos no podría existir.

(3 y 4) Las dos fuerzas nucleares (fuerte y débil) son clave en la creación de la materia a nivel subatómico, siendo la fuerza fuerte la que mantiene unido el núcleo de los átomos mediante la unión de protones y neutrones, desempeñando un papel vital en las reacciones de fusión nuclear como las que alimentan el sol, mientras que la fuerza débil es responsable de la desintegración radiactiva, permitiendo la transformación de un tipo de partícula subatómica en otra, desempeñando un papel vital en las reacciones de fisión nuclear; sin estas fuerzas, los átomos y las estrellas tal y como los conocemos no podrían existir.

Sin embargo, no fue hasta el descubrimiento del papel de los fermiones (partículas de materia) y los bosones de gauge (mediadores de los campos) en las llamadas fuerzas de intercambio que los físicos pudieron entender cómo se relacionan estas fuerzas fundamentales, incluyendo sus semejanzas y diferencias; como se explica a continuación.

De esta forma las interacciones electromagnéticas entre partículas cargadas, ya sean fuerzas de atracción (cargas eléctricas o polos magnéticos con signos contrarios) o de repulsión (cargas eléctricas o polos magnéticos con igual signo) se explican a través del intercambio de fotones (virtuales); que son los portadores de la interacción electromagnética. De manera similar los gluones son los portadores de la interacción nuclear fuerte, mientras que los bosones W y Z lo son de las débiles; como se explica más adelante en detalle.

La otra idea clave para entender los campos cuánticos y las fuerzas de intercambio es la diferencia que existe entre partículas 'reales' y 'virtuales'. Las partículas reales son las que tienen una energía y un impulso (y otras propiedades, como la polarización, la longitud de onda y la velocidad) que se pueden medir directamente con nuestros instrumentos. Mientras que las partículas virtuales son las que solo existen durante un tiempo tan corto que, debido al Principio de Incertidumbre de Heisenberg, no es posible medir sus propiedades directamente en forma exacta -- ver Diagramas de Feynman y Partículas Virtuales para más información.

Por ejemplo, los fotones que constituyen las ondas electromagnéticas clásicas, como los que participan en el conocido efecto fotoeléctrico, son fotones "reales", ya que tienen una energía y un impulso que se pueden medir directamente con los instrumentos apropiados, o se pueden transmitir a otras partículas durante una colisión, o pueden ser absorbidas por otras partículas, etc. Pero cuando se habla de los fotones (o cualquier bosón) que son mediadores de la interacción electromagnética (o cualquier otra interacción fundamental), esos otros fotones son "virtuales". Además, desde el punto de vista del formalismo matemático de la QFT y los diagramas de Feynman, esas partículas virtuales pueden interpretarse como "términos" en una serie infinita que se aproxima a la verdadera fuerza de la interacción, pero debemos tener cuidado de no confundirnos al otorgarles otras propiedades (como la energía y el impulso) que solo poseen los fotones reales.

Interacciones Fundamentales: Fuerzas de Intercambio

Fermiones y Bosones

Fermiones y Bosones

La analogía que normalmente se utiliza para entender el papel de los fermiones y bosones en las fuerzas de intercambio es el de dos jugadores de basketball que continuamente se están pasando una pelota sobre una superficie de hielo sin fricción; los jugadores son los fermiones, la pelota es el bosón, y la superficie sin fricción es el vacío físico. Ese intercambio continuo de la pelota (bosón) entre los jugadores (fermiones) es lo que produce la fuerza de repulsión. Y entonces, cómo se produce una fuerza de atracción, se pregunta uno. Pues la analogía para eso sería que ambos jugadores se aferran a la pelota sin soltarla y cada uno la hala hacia sí. Otra forma de verlo es utilizando la analogía del boomerang de la siguiente imagen con patinadores.

|

| Fuerza de Intercambio (Repulsión) |

|

| Fuerza de Intercambio (Atracción) |

Respecto al término 'bosón' en general, es bueno aclarar que a las partículas elementales con espín entero que son mediadores de las fuerzas de intercambio (fotones, gluones, W, Z, y el Bosón de Higgs) se les suele llamar 'bosones de gauge' para distinguirlos de otros tipos de bosones que pueden ser partículas compuestas, o átomos, o cuasipartículas con espín entero -- ver Teoría de Campos de Gauge más adelante.

En la Teoría Cuántica de Campos (QFT) las fuerzas de intercambio de bosones de gauge se representan gráficamente mediante diagramas de Feynman como se muestra en la siguiente imagen.

|

| Fuerzas de Intercambio: Electromagnética, Débil y Fuerte |

En los diagramas de Feynman, los fotones, mediadores del campo electromagnético, se representan por una sinusoide o por la letra griega gamma minúscula (γ). Los bosones W y Z, portadores de las interacciones nucleares débiles, se representan por una linea discontinua. Los gluones, mediadores de las interacciones nucleares fuertes, se representan por una curva en forma de resorte o por la letra g -- el intercambio del mesón π o pión es un caso particular de interacción fuerte entre bariones (nucleones: protón y neutrón). Mientras que los fermiones (partículas de materia) se representan por una linea continua o una flecha con el símbolo o la inicial del nombre de la partícula, y una barra sobre el nombre si se trata de una antipartícula. Ver Diagramas de Feynman para más información.

El Espín (Spin): El número cuántico más importante

Diferencia entre Fermiones y Bosones

Diferencia entre Fermiones y Bosones

Las partículas elementales pueden tener varias propiedades intrínsecas, como masa en reposo, carga eléctrica, momentum angular y su correspondiente momento magnético, etc. Algunas de estas propiedades son cuánticas, lo cual significa que sus valores no son continuos sino discretos, es decir, que solo pueden tener valores que son múltiplos de una cierta cantidad discreta llamada "quantum". Estas propiedades cuánticas se describen por números cuánticos que definen el estado cuántico de una partícula o sistema de partículas.

Por ejemplo, en física atómica el estado de un átomo se define por un conjunto de cuatro números (n,l,m,s) según el modelo atómico de los orbitales. Uno de esos números es el número cuántico del spin (s) que se observa experimentalmente en la estructura fina de las líneas espectrales de los átomos debido a la interacción del espín electrónico con el campo magnético (Efecto Zeeman). El espin se explica teóricamente a través de correcciones relativistas a la ecuación de Schrödinger. Estas correcciones también pueden ser obtenidas en el límite no relativista de la ecuación de Dirac, ya que la teoría de Dirac incorpora de manera natural la relatividad y las interacciones de espín.

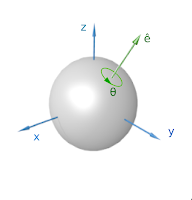

El término "spin" en inglés ("giro", en español) se debe a que inicialmente se pensó que dicha propiedad física era causada por el giro del electrón sobre su propio eje. También en el caso de los fotones el spin se relacionó con la polarización de las ondas electromagnéticas clásicas, como se explica en la sección sobre Electrodinámica Cuántica (Diagramas de Feynman). Sin embargo en la actualidad el spin se entiende como un efecto puramente cuántico-relativista intrínseco de cada partícula fundamental, que no tiene analogía en física clásica (el electrón no es una pequeña esfera ni tampoco gira sobre su eje), y en realidad lo que el spin representa es una simetría fundamental; la simetría de la Función de Onda ante una rotación, como se explica a continuación.

|

| Interpretación clásica del spin como rotación del electrón |

En física de partículas elementales una de las propiedades que siempre vamos a encontrar es el Espín (Spin, en inglés), el cual es un número cuántico que representa el momentum angular "innato" de la partícula, y cuyo valor (entero o semientero) refreja una simetría intrínseca; la simetría ante la rotación. Así por ejemplo, los bosones con espín 1 retornan al mismo estado después de ser rotados una vuelta completa. Sin embargo, los fermiones con espín 1/2 necesitan completar dos rotaciones completas para poder regresar al mismo estado. Las partículas con espín 0, como el Bosón de Higgs, no tienen momentum angular intrínseco por lo que su campo se denomina 'escalar'. Teóricamente además pudieran existir partículas con espín 2 que regresarían a su mismo estado después de media vuelta, y tales campos se denominan 'tensoriales', como el teorizado Gravitón; aunque el Gravitón no es parte del Modelo Estándar y aún no se han encontrado partículas con espín 2.

El espín a su vez puede tener una relación con el momentum (dirección y cantidad de movimiento lineal de la partícula) a través de otras propiedades fundamentales llamadas Helicidad y Quiralidad (Chirality, en inglés). La Helicidad de una partícula se define como Dextrógira si la dirección de su espín coincide con la dirección de su movimiento; y es Levógira si las direcciones del espín y del movimiento son opuestas. El concepto de Quiralidad (Chirality) es más abstracto, y está determinado por como la partícula se representa dextrógira o levógira bajo una transformación del Grupo de Simetría de Poincaré (teoría especial de la relatividad). La Helicidad también se relaciona con la no conservación de la Paridad en las interacciones débiles -- ver Notas sobre Simetrías al final.

¿Pero por qué el Espín es tan importante? La respuesta tiene que ver con dos cosas: (1) La diferencia entre fermiones y bosones en los ensambles de muchas partículas de cada clase, es decir, las diferencias en sus distribuciones estadísticas en función de la temperatura; y (2) El diferente rol que tienen los fermiones y bosones en las fuerzas de intercambio, es decir, en las fuerzas fundamentales de la naturaleza.

Una propiedad de los fermiones en general es que tienen espín semientero, por lo cual obedecen la Estadística de Fermi-Dirac y el Principio de Exclusión de Pauli. Esto significa que no pueden existir dos fermiones en el mismo estado cuántico al mismo tiempo. Si estas partículas no tuvieran esta propiedad, toda la materia podría simplemente colapsar en un solo punto. Es gracias a los fermiones que existe la materia sólida, por ejemplo.

Por otra parte los bosones que tienen espín entero obedecen la Estadística de Bose-Einstein, lo cual significa que pueden existir dos o más bosones en el mismo estado y al mismo tiempo, es decir, que los bosones tienden a agruparse. Es debido a este agrupamiento de los bosones que por ejemplo tenemos los láseres, que son conjuntos de fotones que ocupan un mismo estado cuántico metaestable cuando son "estimulados", y que luego "disparan juntos" en una especie de reacción en cadena, por así decirlo. El nombre LASER en inglés corresponde a las siglas de "Light Amplification by Stimulated Emission of Radiation", y se refiere a la emisión de un haz de luz paralelo que es coherente y monocromático, y en muchos casos además puede ser polarizado; un efecto óptico que fue demostrado por pimera vez por Gordon Gould en 1957.

Por cierto, esta cualidad de los bosones de poder existir en un mismo estado cuántico también se manifiesta en algunos átomos que tienen espin entero, causando otros interesantes y exóticos fenómenos físicos como la superfluidez (ausencia de viscosidad) en el helio líquido, y la superconductividad (ausencia de resistencia eléctrica) en ciertos materiales a bajas temperatura o altas presiones.

Otra importante cualidad del Espín es su conservación en todas las interacciones entre partítculas elementales. Esto significa que el Espín total (la suma de los espines de todas las partículas pariticpantes en una interacción) se mantiene constante, es decir, tiene el mismo valor antes y después de la interacción. Esta relación entre simetrías y leyes de conservación es muy importante en la física como se verá más adelante en la sección sobre Simetrías y Leyes de Conservación

Fermiones: Leptones y Quarks

Los Fermiones (partículas de materia) se dividen en Quarks y Leptones. Los Quarks son los que participan en las interacciones nucleares fuertes (que mantienen unidos a los protones y neutrones en el núcleo atómico y causan la fusión nuclear) y los Leptones en las interacciones electro-débiles; que unifican las interacciones electromagnéticas con las fuerzas nucleares débiles (causantes de la radioactividad y la fisión nuclear). Históricamente la unificación de las interacciones electro-débiles se debió a Abdus Salam y Steven Weinberg, quienes plantearon la hipótesis de que las fuerzas electromagnéticas y nucleares débiles podrían ser expresiones de una sola fuerza, y que la interacción débil se manifiesta en "corrientes débiles neutras" cuando interactúan ciertas partículas elementales; lo cual se confirmó más tarde.

Los Leptones (del griego "leptos" que significa "pequeño" o "ligero") incluyen al bien conocido electrón con sus dos primos pesados (el muón y el tauón) que poseen carga eléctrica, y a las tres clases de neutrinos correspondientes (neutrino electrónico, muónico y tauónico) que como su nombre indica son neutros. En otras palabras, en el modelo electro-débil, tanto el electrón como el muón y el tauón se consideran 3 variedades (sabores) de una cierta partícula elemental llamada leptón. Estos son los fermiones que participan en las interacciones electro-débiles.

Los Quarks fueron bautizados por el famoso y singular físico Murray Gell-Mann en 1964, a partir de una linea del poema de James Joyce 'Finnegans Wake' (El Velorio de Finnegans) donde se ofrece "Three quarks for Muster Mark", y aunque el uso fonético de la palabra 'quark' en el poema de Joyce en inglés es debatible (puede ser una alusión a 'quart' o 'quawk'), la razón física es que estas partículas tienen la peculiar característica de combinarse en tríos para formar los Hadrones (nombre general dado a las partículas que participan en las interacciones fuertes) del tipo Barión (protones y neutrones que forman el núcleo atómico). Lo cual es posible gracias a que los Quarks tienen carga eléctrica fraccionaria, equivalente a 2/3 o -1/3 de la carga elemental del protón y el electrón.

La Teoría de los Quarks de Gell-Mann, llamada "Quantum Chromodynamics (QCD)", fue confirmada por primera vez a finales de 1967 en los experimentos de "Deep Inelastic Scattering" realizados en el SLAC (Stanford Linear Accelerator) en colaboración con el MIT.

La familia completa de los Quarks se describe a través de propiedades intrísecas (números cuánticos) llamadas "colores" y "sabores". Los colores de los quarks se interpretan como una nueva propiedad física aplicable a las interacciones fuertes llamada "carga de color"; para distinguirla de la "carga eléctrica" que también pueden tener. La analogía que se utiliza es la de los 3 colores primarios que se adicionan para obtener la luz blanca. Por eso se dice que existen 3 "cargas de color", y dado que cada carga de color a su vez puede tener dos valores, entonces en total existirán 6 valores posibles de un cierto número cuántico arbitrariamente llamado "sabor" (flavor, en inglés) -- se cuenta que a Gell-Mann se le ocurrió esa idea en una heladería.

De esta forma los Quarks tienen 3 "colores" (rojo, verde, azul, que definen las formas en que se pueden combinar para formar una partícula sin color) y vienen en 6 "sabores" con los siguientes nombres arbitrarios que se les dieron según fueron descubiertos: Up (arriba), Down (abajo), Charm (encanto), Strange (extraño), Top (cima, también llamado 'Truth'), Bottom (fondo, también llamado 'Beauty'). Por ejemplo, para formar los protones y neutrones del núcleo atómico se requieren 3 quarks de tipo arriba/abajo combinados de la siguiente forma:

2 quark arriba + 1 quark abajo -> 1 protón

1 quark arriba + 2 quark abajo -> 1 neutrón

1 quark arriba + 2 quark abajo -> 1 neutrón

La siguiente animación muestra cómo se unen 3 quarks de tipo arriba/abajo (up/down), intercambiando un gluón, para formar un neutrón en el núcleo atómico; y como la propiedad del "color" de los quarks cambia en el proceso.

|

| Tres Quarks en un Neutrón intercambiando un Gluón |

Solo una definición más para entender cómo las combinaciones de quarks forman los hadrones. A los quarks que determinan los números cuánticos de los hadrones se les llama 'quarks de valencia' (valence quarks, en inglés); por ejemplo los tres quarks arriba/abajo que se muestran en la imagen anterior. Pero además dentro de los hadrones existen los llamados 'sea quarks' en inglés (¿quarks marinos, en español?) que aunque no contribuyen a los números cuánticos observables, sí influyen en las interacciones entre gluones y quarks. Por ejemplo, los 'quarks marinos' se forman cuando un gluón del campo de color se divide; este proceso también funciona a la inversa, ya que la aniquilación de dos quarks marinos produce un gluón. Como nota histórica, un 'quark marino' correspondería a lo que Feynman llamó 'Partón' en su modelo de los hadrones. El resultado de todo esto es un flujo constante de divisiones y creaciones de gluones en los hadrones, conocido coloquialmente como "el mar".

Bosones: Fotones, Gluones, Weak (W) y Zero (Z)

Resumiendo la organización del Modelo Estándar a nivel general vemos que los bosones se dividen en tres clases dependiendo de la interacción o fuerza de la que sean portadores (mediadores del campo). Los fotones, representados por una sinusoide en los diagramas de Feynman o por la letra griega gamma minúscula (γ), son los mediadores del campo electromagnético. Mientras que los gluones, representados por una curva en forma de resorte en los diagramas de Feynman o por la letra g, lo son de las interacciones nucleares fuertes. Estas dos clases de bosones no tienen masa en reposo.

Por otra parte los bosones W y Z, representados por una linea discontinua en los diagramas de Feynman, son de una misma clase que tienen masa en reposo, gracias al llamado 'mecanismo de Higgs' (ver Bosón de Higgs más adelante), y sirven como portadores de las interacciones débiles. La diferencia entre el bosón W (Weak) y el Z (Zero) radica en sus cargas eléctricas (W tiene carga +/- pero Z es neutro) y en sus nombres que les fueron dados en diferentes momentos por razones históricas.

El modelo estándar además asume que la intensidad de la fuerza de acoplamiento entre los leptones y los bosones W y Z es independiente del 'sabor' específico del leptón, ya sean electrones, muones o tauones; a lo cual se le llama 'universalidad del sabor'.

|

| Tabla del Modelo Estándar de las Partículas |

Antimateria: Partículas y Antipartículas

Además cada una de las partículas elementales, incluyendo quarks y leptones, tiene su pareja de antipartícula; la cual sería otra partícula elemental con la misma masa y número cuántico de espín pero con carga eléctrica opuesta. Las partículas sin carga (neutras), como los fotones y los gluones, son su propia antipartícula. El concepto de antipartícula fue propuesto inicialmente por Paul Dirac en 1928 como solución de sus ecuaciones relativistas de la mecánica cuántica, y por primera vez fueron encontradas experimentalmente por Carl Anderson en 1932 cuando descubrió el positrón (la antipartícula del electrón) en los rayos cósmicos.

Por cierto, hay algo que debe notarse sobre los neutrinos y sus antipartículas. Según la definición anterior, los neutrinos, que son neutros ya que no tienen carga eléctica, deberían ser su propia antipartícula. Pero este es un punto que aún se investiga debido a la existencia de otro número cuántico llamado 'carga leptónica', la cual se relaciona con la 'conservación del número leptónico', y que permitiría distinguir los antineutrinos de los neutrinos como partículas con diferentes cargas leptónicas –- ver sección de Problemas No Resueltos más adelante.

Mesones y Bariones: Partículas Intermedias y Núcleo Atómico

Los Hadrones son el nombre general dado a las partículas que participan en las interacciones nucleares fuertes, y se clasifican en Bariones y Mesones según el número de Quarks que los forman. Los Bariones, como por ejemplo los protones y neutrones que constituyen el núcleo atómico, consisten en combinaciones de 3 quarks de tipo arriba/abajo como ya se explicó anteriormente. A los otros tipos de Bariones que no contienen el quark arriba ni el quark abajo se les llama en general Bariones Omega (Ω Baryons).

Ocasionalmente también ocurre que los quarks pueden unirse en parejas de quark-antiquark para formar una clase intermedia de Hadrón llamada Mesones, como los mesones Pi, K, B, D, J/Psi, etc. que se han encontrado en los rayos cósmicos y en diferentes experimentos, como se muestra a continuación. Otra peculiardad de los Mesones es que se comportan como Bosones ya que se componen de parejas de quarks con espines opuestos, dando como resultado partículas compuestas con espín 0 o 1; mientras que los Bariones siempre se comportan como ferminones ya que se componen de tres quarks.

Nótese además que técnicamente los bariones y mesones no son partículas elementales ya que están compuestas de quarks; los cuales (hasta ahora) sí son elementales. No obstante es importante entender el origen de estas partículas compuestas dada su importancia en física nuclear y física atómica.

|

| Hadrones (Bariones y Mesones) como combinaciones de Quarks |

Por ejemplo, en el gráfico anterior vemos que el Mesón Pi o Pión consiste en un quark arriba y un antiquark abajo; aunque esta configuración es inestable y se desintrega generando Muones (los 'primos pesados' de los electrones que abundan en los rayos cósmicos), Neutrinos y Rayos Gamma (fotones de alta energía):

1 quark arriba + 1 antiquark abajo -> 1 pión

1 pión -> 1 muón + 1 neutrino electrónico

1 muón -> 1 electrón + 1 (anti) neutrino electrónico + 1 neutrino muónico

1 pión -> 1 muón + 1 neutrino electrónico

1 muón -> 1 electrón + 1 (anti) neutrino electrónico + 1 neutrino muónico

Los siguientes diagramas de Feynman describen en detalle cómo ocurren las desintegraciones mencionadas anteriromente para el Pión y el Muón, a través de bosones W+ o W-, que son mediadores de las interacciones débiles:

|

| Diagrama de Feynman de la desintegración del Pión |

|

| Diagrama de Feynman de la desintegración del Muón |

Como también es posible la existencia de otras exóticas partículas basadas en combinaciones de 4 o 5 quarks, como el tetraquark (2 quarks con 2 antiquarks) y el pentaquark (4 quarks con 1 antiquark) las cuales son muy inestables y dificiles de detectar.

Estas características de los quarks se representan matemáticamente a través de un Grupo de Simetría denominado SU(3) o matrices de Gell-Mann -- Ver Nota al final sobre la importancia de estas teorías de simetría en la física actual.

Buscando el Bosón de Higgs: La Partícula de Dios

Además de las 16 partículas elementales mencionadas anteriormente, el modelo estándar incluye el Bosón Escalar de Higgs (mostrado en el centro del gráfico a continuación) que tiene Espín 0 y cuyo campo (o mejor dicho, las exitaciones cuánticas de su campo) genera la masa en reposo del resto de las partículas con las cuales interactúa, por lo cual se le suele llamar 'la partícula de Dios'.

|

| Modelo Estándar de las Partículas Elementales (haga click para ampliar) |

El campo de Higgs es un campo cuántico que llena todo el Universo y la creación de masa ocurre gracias a un proceso físico de rompimiento de la simetría electro-débil llamado Mecanismo de Higgs.

|

| Desintegración del Higgs en 2 fotones según fue registrado en el CERN |

La idea del bosón de Higgs fue propuesta por Peter Higgs, François Englert y otros cuatro físicos teóricos en 1964 para explicar por qué algunas partículas elementales tienen masa. Sin embargo, su existencia permaneció como una teoría solamente hasta que en el 2012 fue detectado por primera vez en experimentos realizados en el LHC del CERN; a través de una colaboración entre el ATLAS y el CMS.

¿Pero cómo pudieron encontrar el bosón de Higgs? Para entender cómo trabajan los físicos experimentales, diseñando experimentos, construyendo laboratorios (que a veces son gigantes), realizando mediciones (a veces muy complejas) y contrastando los resultados experimentales con las predicciones de la teoría, primero es bueno señalar que como parte de este proceso los físicos aplican la llamada 'teoría de errores'. La teoría de errores distingue entre dos tipos de errores (aleatorios y sistemáticos) y enseña, entre otras cosas, que para reducir los posibles errores aleatorios de la medición, los experimentos deben ser repetidos muchas veces, para luego calcular el 'valor esperado' de las mediciones (o ´valor promedio´ asumiendo una Distribución Normal o Campana de Gauss) utilizando métodos estadísticos sobre los datos obtenidos. Además, para describir cuán precisos y significativos son los resultados experimentales obtenidos, los físicos utilizan el concepto de 'desviación estándar' que en estadística se representa con la letra griega sigma: σ. Así por ejemplo, en el experimento para encontrar el bosón de Higgs, el valor establecido para sigma fue 5, que es considerado el umbral mínimo para poder declarar un resultado como significativo en experimentos con particulas elementales.

De esta forma, lo que se hizo en el experimento fue medir la distribución energética de los fotones (rayos gamma) que resultan de ciertos eventos de colisión entre partículas y plotear el numero de eventos contra la energía de los fotones emitidos, para así comparar los resultados experimentales contra la predicción de la teoría, como se muestra el siguiente gráfico.

Entonces, dado que la teoría predecía que la distribución de energía de los fotones debía dar una curva monótona decreciente, pero en los resultados experimentales claramente se notaba un pico (un "bump" en inglés) para un cierto valor de energía, y dado que ese "bump" era suficientemente significativo, eso demostró experimentalmente la presencia de una nueva partícula, cuya masa corresponde al valor de energía del "bump", según la relación entre masa y energía E = mc2, aproximadamente 125.35 GeV (según los más recientes resultados); que es precisamente el valor de la masa del bosón de Higgs que se buscaba.

Masa en Reposo de las Partículas: Tres Generaciones

Los fermiones en general además se clasifican dentro de tres generaciones con iguales números cuánticos de carga y espín, pero con diferencias en sus masas en reposo y números cuánticos de "color" y "sabor", según se muestra en la tabla anterior que describe las 16 partículas elementales.

De esta forma el Top Quark (quark cima) sería la más pesada de las partículas elementales, y por tanto la que tiene mayor energía según la relación E = mc2, aproximadamente 173 GeV, por lo cual solo puede ser detectada en aceleradores de partículas que alcanzan esos altos niveles de energía; como el Tevatrón del Fermilab o en el LHC del CERN. Cómparase por ejemplo con las masas de los protones y neutrones que son 0.9 GeV aproximadamente, y las de los top-down quarks que son del orden de 0.1 GeV. Y entre los leptones, el muón (1.777 GeV) y el tauón (0.1057 GeV) serían los 'primos pesados' del electrón, cuya masa es muy pequeña (511 keV).

En cuanto a los neutrinos, vemos que el Modelo Estándar define tres clases que corresponden a las tres generaciones de leptones que existen (electrón, muón, tauón), con los siguientes nombres relacionados: neutrino electrónico, neutrino muónico y neutrino tauónico. Sobre los neutrinos además debe notarse que el Modelo Estándar predice que los neutrinos deberían tener masa nula. Sin embargo experimentalmente se ha encontrado que los neutrinos pueden tener una masa que, aunque sea muy pequeña, no es nula, y este es precisamente uno de los problemas no resueltos del Modelo Estándar –- ver sección de Problemas No Resueltos más adelante.

Teorías de Simetría: ¿Por qué Modelo y no Teoría?

El Modelo Estándar con razón es considerado por muchos físicos como el mayor logro de la física contemporánea, ya que constituye la culminación de muchos años de trabajo en varias importantes teorías fisico-matemáticas, como la Electrodinámica Cuántica (QED), la Cromodinámica Cuántica (QCD o Teoría de los Quarks), la unificación de las interacciones electromagnéticas y las nucleares débiles en la Teoría de la Interacción Electrodébil SU(2), y la Conservación de la Hipercarga U(1) que combina la carga eléctrica con el isoespín. El isoespín (espín isotópico o espín isobárico) es un número cuántico relacionado con la interacción fuerte y aplicado a las interacciones del neutrón y el protón, cuyo nombre incluye "spin" porque su descripción en la mecánica cuántica es matemáticamente similar a la del momento angular.

Estas teorías de tipo SU(n), donde n es el grado de un grupo de simetría 'Special Unitary' de Lie, técnicamente son teorías de campo de gauge (teorías de recalibración) de Yang-Mills, basadas en el algebra de los Grupos de Simetría de Lie (no-Abelianos) aplicadas al Lagrangiano de la ecuación que describe el campo en cuestión, así como sus leyes de conservación. Por eso desde el punto de vista matemático el Modelo Estándar es considerado un producto de tres teorías de simetrías del tipo: SU(3) × SU(2) × U(1).

Y de ahí el nombre de Modelo y no de Teoría, ya que no se trata de una única teoría, sino de la síntesis de varias teorías basadas en la Mecánica Cuántica y la Teoría Cuántica de Campos, que en su conjunto nos ofrecen la mejor descripción científica sobre como funciona nuestro universo a nivel de física fundamental.

Como curiosidad matemática, cuando se escribe la ecuación completa del Modelo Lagrangiano (basándose en el formalismo Lagrangiano de la QFT) la cual es una expresión matemática que resume el Modelo Estándar de física de partículas, utilizando una notación compacta con los símbolos y operadores de la teoría cuántica de campos (como 'derivadas covariantes', 'tensores de intensidad de campo', 'matrices de Dirac' y 'generadores de grupos de calibración', etc.) se obtiene lo que se considera la ecuación más larga de la física, la cual incluye una larga lista de términos y factores (constantes de acoplamiento) que dan cuenta de todas las posibles interacciones y simetrías del Modelo Estándar; como se muestra en la siguiente imagen.

|

| Modelo Lagrangiano del SM (haga click para ampliar) |

Por otro lado vale notar que no obstante la 'belleza matemática' de las simetrías contenidas en estas teorías, el éxito de una teoría física estriba en ser capaz de no solo poder explicar fenómenos físicos observados hasta el momento, sino en poder hacer predicciones que puedan ser verificadas empíricamente, ya sea en experimentos de laboratorio diseñandos al efecto o en observaciones astronómicas y cosmológicas; según requiere el método científico. Y en ese sentido hay que decir que el Modelo Estándar ha sido excepcionalmente exitoso ya que sus predicciones han podido ser ampliamente verificadas experimentalmente.

Solo como ejemplo. Consideremos el cálculo del momento magnético del electrón, el cual es una medida de cuán fuerte se 'tambalea' una partícula en un campo magnético. Pues resulta que el Modelo Estándar da el valor correcto del momento magnético del electrón con 14 cifras decimales (-1.00115965218178 en unidades de Magnetones de Bohr). Esta predicción es excepcionalmente precisa y coincide con las mediciones experimentales con un asombroso nivel de exactitud, aproximadamente 1 parte en un billón... ¡La predicción más precisa de toda la ciencia a partir de primeros principios!

Problemas No Resueltos

No obstante todo lo anterior sobre la belleza matemática del Modelo Estándar y su excepcional poder explicativo sobre las partículas elementales y las fuerzas fundamentales de la naturaleza, hay físicos hoy en día que consideran que el modelo es incompleto y necesita ser revisado para poder resolver los siguientes problemas que el modelo aún no explica:

- La masa de los neutrinos: El Modelo Estándar no explica la masa de los neutrinos. La cuestión de la masa de los neutrinos es muy importante porque los neutrinos son las partículas más abundantes del universo, por lo tanto el hecho que los neutrinos tengan masa (aunque sea muy pequeña) les permitiría interactuar con el campo gravitatorio, lo cual resulta ser crucial en la Cosmología Física porque afecta grandemente el cálculo de la masa total del universo y eso tiene otras implicaciones en cuanto a la topología del universo; su curvatura, su evolución, etc. Pero si el Modelo Estándar requiere que los neutrinos no tengan masa, entonces eso es un problema que los físicos tendrán que resolver.

- La masa de los bosones: El Modelo Estándar elegantemente predice que la masa en reposo del bosón W deber ser 80.36 giga-electron-volts (GeV). Sin embargo, recientemente el Fermilab reportó que en experimentos muy precisos, realizados con el acelerador de parítculas Tevatron (por el grupo llamado Collider Detector at Fermilab o CDF), se ha encontrado que la masa del bosón W es 80.43 GeV, con una incertidumbre de solo 0.0094 GeV. Esto es una discrepancia de 7-sigma entre el valor experimental y el teórico, y representa la más robusta anomalía experimental que se ha encontrado en las predicciones del Modelo Estándar; lo cual tiene que ser explicado, o el modelo debe ser revisado.

El otro bosón cuya masa ha sido medida con gran precisión y también difiere del valor teórico es el bosón W que es uno de los mediadores de las interacciones débiles. En este caso los físicos del CDF han descubierto que la masa del bosón W es un 0.1% mayor que el valor predicho por el Modelo Estándar. Esta parece ser una pequeña discrepancia, pero no obstante podría presagiar un gran cambio en la física fundamental, ya que si el exceso de masa del W puede confirmarse de forma independiente, por ejemplo en otros experimentos realizados en el LHC, el hallazgo podría implicar la existencia de partículas o fuerzas no descubiertas y provocaría la primera reescritura importante de las leyes de la física cuántica en medio siglo. - El espín del protón: El espín del protón debería ser igual a la suma de los espín de los tres quarks que lo componen. Sin embargo, en 1988 en la European Muon Collaboration (EMC) del CERN, descubrieron que el espín neto de los tres quarks solamente suma el 24% del espín del protón. Esta significativa discrepancia es otro probema que el Modelo Estándar debe resolver. Para ayudar a resolver este misterio en Estados Unidos recientemente se ha construido un nueva clase de acelerador de partículas llamado EIC (Electron-Ion Collider) en el Brookhaven National Laboratory de Long Island, New York. .

- No explica la anomalía en la Conservación del Número Bariónico, el cual debería conservarse el todas las interacciones en el Modelo Estándar. El Número Bariónico se define como un tercio de la diferencia entre el número de quarks menos el número de antiquarks. De esta forma los bariones (protones y neutrones) tienen número bariónico 1 mientras que para los mesones es 0; como también para los leptones que no participan en la interacciones fuertes el número bariónico es 0. La excepción que debe ser explicada es la llamada 'anomalía Adler–Bell–Jackiw' en las interacciones electrodébiles. También, si la predicciones de la Supersimetría SUSY resultan ser ciertas, los bariones podrian convertirse en leptones, lo cual violaría la conservación del número bariónico.

- No explica la anomalía en la Conservación del Número Leptónico, el cual siempre debería conservarse según el Modelo Estándar. Sin embrago, existen algunos fenómenos experimentales, como la llamada 'Oscilación de Neutrinos' y la 'Doble Desintegración Beta', donde se ha comprobado que el número leptónico no siempre se conserva. Lo cual tiene que ver con la cuestión de si los neutrinos son sus propias antipartículas, o no. Técnicamente la pregunta sería si los neutrinos son fermiones de tipo Majorana que se caracteriza por ser su propia antipartícula, o no.

Los físicos contemporáneos tienen por costumbre darle nombres metafóricos o alegóricos a sus teorías y descubrimientos. Así por ejemplo en el Modelo Estándar tenemos varias partículas 'celestiales', como la partícula de Dios (el bosón de Higgs), la partícula ángel (el fermión de Majorana) y las partículas fantasma (los neutrinos). El nombre de 'partícula angel' es una referencia a la novela de Dan Brown 'Ángeles y Demonios', donde se presenta una bomba creada por la aniquilación de materia y antimateria. - No incluye el Gravitón, es decir, el bosón de gauge tensorial de la Gravitación Cuántica de Bucles (en inglés Loop Quantum Gravity o LQG); la teoría matemática que unifica la mecánica cuántica con la teoría general de la relatividad de Einstein (asumiendo una geometría cuantificada a través de 'bucles' del espacio-tiempo). Aunque esto realmente no es un 'problema' como tal, sino más bien una limitación en al alcance del actual Modelo Estándar que aún no incluye la gravitación.

- No incluye la Supersimetría (SUSY) predicha por la Teoría de las Cuerdas (que asume que las partículas elementales aparentemente puntuales son estados vibracionales de un objeto más básico llamado 'cuerda'), en la cual cada fermión conocido hasta ahora tendría una pareja de tipo bosón mucho más pasada y viceversa para los bosones conocidos. Aunque, al igual que el punto anterior, el hecho de no incluir la Supersimetría no es realmente un 'problema', ya que la Supersimetría es una hipótesis que aún no se ha demostrado experimentalmente.

- Violación de la Paridad y Simetría CPT: En física, una transformación de la paridad (también llamada inversión de la paridad) es el cambio simultáneo en el signo de todas las coordenadas espaciales, como si fuera una reflexión en un espejo. Inicialmente en la física de partículas elementales se pensó que la propiedad de la Paridad (representada por la letra P) debía conservarse en todas las interacciones, es decir, que el universo debería ser simétrico respecto a una inversión de la Paridad -- simétrico respecto a una reflexión en un espejo tridimensional imaginario. Otra forma de entender la Paridad es diciendo que en el universo la izquierda y la derecha son equiivalentes. Sin embargo, luego del descubrimiento de los neutrinos, experimentalmente se demostró que en las interacciones débiles ocurre una violación de la Paridad – la Paridad no se conserva en las interacciones débiles.

Esto tiene que ver con la extrañeza de que en la naturaleza no existen neutrinos dextrógiros (helicidad derecha) sino solo levógiros (helicidad izquierda). Sin embargo luego los físicos generalizaron la simetría de la Paridad para incluir la conjugación de la Carga eléctrica (representada por C) considerando que los antineutrinos solo existen como dextrógiros, y entonces concluyeron que la combinación CP (conjugación de la Carga más inversión de la Paridad) sí debería conservarse; a lo cual se llamó Simetría CP. Pero en la naturaleza a nivel fundamental las cosas no son tan simples como algunos quisieran, y de nuevo experimentalmente se demostró que también la Simetría CP es violada en interacciones con Kaones (mesones K). Por lo cual se hizo necesario incluir la inversión del Tiempo (representado por T) y de esa forma concluyeron que en las interacciones débiles solo la combinación de CPT se conserva; a lo cual se le llama Simetría CPT.

Por cierto, la violación de la paridad en las interacciones débiles se cree que es la razón física por la cual toda la vida biológica se basa en ADN dextrógiro, pero no levógiro. La explicación usual es que los Rayos Cósmicos que llegan a la atmósfera de la tierra producen Muones, lo cuales son afectados por las interacciones débiles. Dichos muones han interactuado con las moléculas de ADN desde el principio de la vida en la Tierra, lo cual por un lado ha inhibido la creación del ADN levógiro, mientras que por otro han ionizado y aumentado las mutaciones del ADN dextrógiro, dándole un boom a la vida y a la prevalencia del ADN dextrógiro en la Tierra.

¿Pero por qué los neutrinos son tan extraños? ¿O será que nos falta algo en el Modelo?. - Conservación de la CP Fuerte:

El problema de la 'CP Fuerte' (Strong CP, en inglés), es decir, la conservación de la combinación CP (Conjugación de Carga y Paridad) en las interacciones fuertes, es una pregunta desconcertante en la física de partículas: ¿Por qué la Cromodinámica Cuántica (QCD) parece preservar la Simetría CP?

En física de partículas, CP representa la combinación de simetría de conjugación de carga (C) y simetría de paridad (P). De acuerdo con la formulación matemática actual de la cromodinámica cuántica, debería ocurrir una violación de la simetría CP en las interacciones fuertes. Sin embargo, nunca se ha visto ninguna violación de la simetría CP en ningún experimento que involucre solo la interacción fuerte. Como no hay una razón conocida en QCD para que necesariamente se conserve, este es un problema de "ajuste fino" conocido como el Problema de CP Fuerte (Strong CP Problem).

Este problema se también se relaciona con la búsqueda del AXION, que sería una nueva partícula elemental que podría resolver el problema; aunque tal partícula aún no se ha encontrado experimentalmente.

Misterios de la Cosmología Fisica: Posibles Soluciones

El Modelo Estándar no explica algunos misterios de la Cosmología Fisica, como por ejemplo:

- La materia oscura que mantiene las galaxias cohesionadas en sus formas espirales, lo cual no se puede explicar solo mediante la materia visible. Y aunque para explicar la materia oscura se han propuesto nuevos tipos de partículas, como los MACHO (Massive Astrophysical Compact Halo Object) y los WIMP (Weakly Interacting Massive Particle), las cuales están siendo buscadas en los experimentos subterráneos de XENON y LUX, en realidad estas exóticas partículas no han sido encontradas aún. Otro candidato que se ha propuesto para explicar la materia oscura es el AXION, que además podría explicar las anomalías debido al rompimiento de la simetría CP que se mencionó en el punto anterior.

Por otra parte también se ha propuesto la hipótesis de una quinta fuerza fundamental en la naturaleza, la cual parece estar soportada por un experimento que sugiere la existencia de una nueva partícula llamada X17, cuyo nombre le fue dado por ser una incógnita de la cual solo se conoce su masa que debe ser 17 MeV. Sin embargo muchos físicos dudan de la existencia de una quinta fuerza y los experimentos para confirmar la quinta fuerza aún se estan realizando.

Otra hipótesis alternativa que se ha propuesto para explicar la materia oscura es la llamada 'dinámica newtoniana modificada' o MOND (Modified Newtonian Dynamics, en inglés) que plantea la hipótesis de que la gravitación newtoniana cambia para aceleraciones menores que 10-10 m/s2 y por tanto debe ser modificada o 'ajustada'. Incluyéndo también la variante relativista que propone modificar las ecuaciones del campo gravitatorio de Einstein. Aunque estas teorías de la gravitación modificada tipo MOND tienen sus propios problemas y aún no ha podido explicar algunos resultados experimentales, como la radiación de fondo de microondas remanente del Big Bang. - La energía oscura que causa la expansión acelerada del universo. Lo cual se comprueba a través de la medición de la Constante de Hubble, la cual es una de las 'constantes' fundamentales de la Cosmología que representa la velocidad de expansión del universo desde el Big Bang hasta ahora; como se explica en el blog sobre Misterios de la Cosmología. Algunos físicos creen que la energía oscura se debe a la existencia de una nueva partícula llamada AXION. Los AXION a su vez se relacionarían con los WIMP de la materia oscura fría; pero esa hipótesis no ha sido comprobada aún, aunque su búsqueda ya ha comenzado. Los AXION también se han propuesto como solución al problema de la materia oscura.

- La asimetría entre materia y antimateria; que de haber sido perfectamente simétricas, las partículas y las antipartículas que tienen cargas opuestas se habrían aniquilado hace mucho tiempo, y el universo conocido que esta hecho mayormente de materia no podría haber existido como tal. Esta asimetría se espera pueda ser explicada a través de algunos experimentos con neutrinos como los que se realizan en el DUNE, o los experimentos del CERN sobre la violación de la simetría CP; donde C representa la simetría ante la inversión de la Carga y P la simetría ante una transformación de Paridad (cambio simultáneo en el signo de toda coordenada espacial; como si fuera una reflexión en el espejo).

Una explicación alternativa del por qué existe un universo hecho de materia, pero no un anti-universo hecho de anti-materia, sería que la masa de una partícula no resulte ser exactamente igual a la de su pareja de antipartícula, como teóricamente se ha supuesto; y para lo cual los físicos del CERN están trabajando en experimentos que puedan detectar posibles pequeñísimas diferencias de masa entre las parejas de partícula-antipartícula.

Y de esta forma quizás los físicos podrán finalmente responder esa vieja pregunta de la filosofía: ¿Por qué hay algo en vez de nada?

Y por si lo anterior fuera poco, aun otra hipótesis que algunos físicos han adelantado para explicar la materia oscura es el llamado Bosón Madala, que sería un 'bosón oscuro' que surge de una hipotética interacción entre el Higgs y el Top Quark, de forma tal que no emite fotones; y de ahí lo de oscuro.

Estos problemas no resueltos de la física son la razón que motiva a muchos incansables científicos, en laboratorios y universidades apoyados por gobiernos y organizaciones privadas, en varios países, quienes invierten gran cantidad de recursos, tanto en tiempo como en dinero, en investigaciones teóricas y experimentales que tratan de responder estas preguntas fundamentales sobre cómo realmente funciona nuestro universo.

Partículas y Cuasipartículas

Aplicaciones de la Mecánica Cuántica

Aplicaciones de la Mecánica Cuántica

En mecánica cuántica, las Cuasipartículas son fenómenos emergentes que ocurren cuando un sistema microscópicamente complejo, como un sólido, se comporta como si contuviera diferentes partículas que interactúan débilmente en el vacío. No obstante, las cuasipartículas no deben ser confundidades con las partículas elementales. A diferencia de las partículas elementales 'reales' en sentido que existen 'individualmente', las cuasipartículas son un modelo de entidades que se comportan como partículas cuánticas pero que realmente surgen de las 'excitaciones colectivas' de ensambles de muchas partículas; y de ahí el prefijo "cuasi".

El concepto de cuasipartículas es muy importante en la física de la materia condensada porque puede simplificar el problema de muchos cuerpos en la mecánica cuántica, lo cual puede tener grandes aplicaciones prácticas en el estudio de los varios estados de la materia conocidos, así como en nuevos estados de la materia aún deconocidos que pueden existir nivel cuántico. Los 'estados de la materia' describen cómo las partículas pueden interactuar entre sí, dando lugar a estructuras y diversas formas de comportarse. Por ejemplo, si los átomos se bloquean en su lugar en una red cristalina, tendremos un sólido. Si se dejan fluir con mayor libertad, tendremos un líquido o un gas. Si se fuerzan a ser separados en sus componentes cargadas, tendremos un plasma, etc. Pero el paisaje cuántico proporciona formas aún más extrañas para que las partículas interactúen, lo que permite comportamientos únicos que se describen mejor en términos de posibilidades y energía. Veamos algunos de los ejemplos que tienen mayores aplicaciones prácticas.

En Física de Semiconductores, la cual es una especialidad que se estudia como parte de la Física del Estado Sólido, cuando un electrón absorbe energía y cambia su estado al 'saltar' de la banda de valencia a la banda de conducción, su movimiento se ve perturbado de manera compleja por sus interacciones con otros electrones y otros núcleos atómicos del propio material semiconductor o de las impurezas que se le añaden (dopaje), por lo cual dicho electrón se comportará como si tuviera una 'masa efectiva' diferente a la que tendría viajando sin perturbaciones en el vacío. A dichos electrones en un semiconductor se les llama cuasipartícula de electrones.

El caso complementario sería el movimiento agregado del resto de los electrones en la banda de valencia de un semiconductor cuando un electrón ha pasado a la banda de conducción, que colectivamente se comportan como si el material contuviera cuasipartículas cargadas positivamente llamadas huecos de electrones. Pero nótese que la cuasiparticula 'hueco' en el semiconductor, aunque tenga 'carga efectiva' positiva, no es lo mismo que la partícula elemental positrón que es la pareja de antimateria del electrón real con carga positiva.

|

| Niveles de Energía y Parejas electrón-hueco en un Semiconductor Los electrones son los círculos rojos y los huecos son los blancos |

Transistores: Precisamente esta posibilidad de modificar la conductividad en semiconductores como el silicio en una forma controlada, añadiendo impurezas tipo N o P que alteran la concentración de electrones o huecos en el material, fue la clave que permitió el invento de los transistores. Históricamente el primer transistor funcional fue el llamado Transistor de Punta de Contacto, inventado en 1947 por los físicos John Bardeen y Walter Brattain, mientras trabajaban con William Shockley en Bell Labs. Bardeen por cierto es la única persona que ha recibido dos premios Nobel de Física, uno por el descubrimiento del transistor (1956) y otro por la superconductividad (1976) -- Ver Teoría BCS y 'par de Cooper' más adelante.

Luego se desarrolló el Transistor Bipolar de Juntura (P-N-P y N-P-N), el cual reemplazó al Transistor de Punta de Contacto original, y gracias a su bajo costo y predictibilidad de producción, abrió la puerta al gran campo de los circuitos integrados y la electrónica de estado sólido. Lo cual luego permitió el desarrollo de nuevas clases de transistores como el Transistor de Efecto de Campo (FET y MOSFET) y el CMOS (Complementary Metal Oxide Semiconductor) que es más eficiente por su baja potencia, con sus muchas aplicaciones, como los microprocesadores y las computadoras personales, de las que disfrutamos hoy.

A propósito de los Electrones y los Huecos en los semiconductores mencionados anteriormente. Tanto en semiconductores como en aislantes existen otras clases de cuasipartículas llamadas Excitón y Polarón, las cuales son casos particulares del Solitón y consisten en parejas de electrón y hueco que están ligados a través de los fonones acústicos. El Fonón es una cuasi partícula derivada de las vibraciones de los átomos en un sólido cristalino; y por eso a veces le llaman 'quantum acústico' en física de estado sólido. Por su parte el Excitón se considera una excitación elemental de materia condensada que puede transportar energía sin transportar carga eléctrica neta, y por eso son de gran interés en la física de aplicaciones. De esta forma una combinación acústica de exitón y polarón podría ser el fundamento de los futuros materiales que se utilizarán para fabricar los microchips de las computadoras que prometen ir más allá de las limitaciones del silicio.

Superconductividad: La superconductividad es la propiedad de tener resistencia eléctrica cero en algunas sustancias a temperaturas absolutas muy bajas o presiones muy altas. La explicación de este fenómeno se basa en la aparición del llamado Par de Cooper (Cooper pair) bajo ciertas condiciones, y en una cuasipartícula o excitación colectiva llamada Fonón; una cuasi partícula derivada de las vibraciones de los átomos en un sólido cristalino. Entonces, el acoplamiento de dos electrones a través de la interacción con los fonones de la red cristalina es lo que causa la existencia del Par de Cooper (Cooper pair) que explica la superconductividad; como una transición de fase cuantica que ocurre en ciertos materiales a bajas temperaturas o altas presiones. Según la teoría actual de la superconductividad, el Par de Cooper se comporta como un bosón y se forma cuando una pareja de electrones se ligan y se comportan como si se atrajeran, pese a tener carga de igual signo, debido a que interaccionan a través de la red cristalina formada por los iones positivos del metal.

A propósito de la teoría de la superconductividad basada en el par de Cooper, llamada Teoría BCS (teoría de Bardeen, Cooper y Schrieffer), con ella sucede lo que con muchas otras buenas teorías de la física, que explican muchas de las características de un cierto fenómeno físico, pero no todas, y por eso algunos la consideran incompleta. Por ejemplo, la Teoría BCS no explica la superconductividad en la juntura de Josephson (Josephson junction) basada en el efecto túnel en superconductores, la cual se utiliza en supercomputadoras y computadoras cuánticas. Ni tampoco predice la superconductividad a temperatura ambiente, por ejemplo en el material Grafeno (una sustancia compuesta de láminas de un átomo de espesor de carbono puro, con átomos organizados en un patrón regular hexagonal, parecido al grafito); el santo grial de la eficiencia energética. Por eso los físicos teóricos de hoy continúan buscando una teoría más general de la superconductividad.

BEC (Condensado Bose-Einstein): Un Condensado de Bose-Einstein (Bose-Einstein Condensate; BEC) es un estado de la materia que se forma cuando un gas que consta de bosones (partículas cuánticas con spin entero) se enfría a temperaturas bastante cercanas al cero absoluto y ocurre un cambio de fase, por lo cual a veces le llaman el 'quinto estado de la materia'; que es diferente a los otros cuatro estados físicos conocidos: sólido, líquido, gas y plasma. Los bosones pueden ser partículas elementales, como los fotones, o partículas compuestas, e incluso pueden ser cuasipartículas.

El Condensado de Bose-Einsten es importante en las computadoras cuánticas dada la posibilidad de almacenar qubits de esta forma; lo cual es prometedor porque los condensados de bosones parecen ser menos sensibles a la decoherencia, comparados con otras opciones.

Condensado Fermiónico: Si bien el Condensado de Bose-Einstein es considerado el 'quinto estado de la materia', entonces el Condensado Fermiónico debe ser considerado el 'sexto estado de la materia'. El Condensado Fermiónico es un estado superfluído de la materia formado por partículas fermiónicas a temperaturas extremadamente bajas, similar a un condensado de Bose-Einstein, pero con fermiones en lugar de bosones. Mientras que los fermiones individuales normalmente siguen el Principio de Exclusión de Pauli, lo que impide que ocupen el mismo estado cuántico, en el caso del Condensado Fermiónico ellos pueden emparejarse para formar bosones compuestos, que luego pueden condensarse en un estado superfluido.

Otras Cuasipartículas: También tenemos el Plasmón, una partícula derivada de la oscilación del plasma en la cual los electrones pierden su individualidad, cuyo estudio tiene gran importancia en los esfuerzos por lograr la fusión nuclear controlada; el santo grial de la producción de energía. Sin embargo, la masa efectiva de esta cuasipartícula suele ser tan grande que los plasmones no pueden formarse con las energías disponibles a temperatura ambiente. Por otro lado, algunos físicos teóricos han predicho la existencia de otra cuasipartícula relacioanada que han llamado Demonio (Demon, en inglés), pero que a diferencia del Plasmón, este Demon sería neutro y tendría masa efectiva nula, por lo cual es muy difícil de detectar en experimentos; y de ahí el otro sobrenombre de 'el elusivo demonio' de la física de partículas.

Recientemente además se ha confirmado el descubimiento de un nuevo tipo de cuasipartícula llamada Anyón, la cual es muy importante porque los Anyones están en el centro de un esfuerzo para construir una computadora cuántica que funcione en la práctica, es decir, que sea capaz de auto corregir los errores que se producen por la decoherencia (pérdida del estado de entanglement) entre los Qbits. Esto es posible gracias a algunas peculiares propiedades de los Anyones como el hecho de que solo ocurren en sistemas bidimensionales, con propiedades mucho menos restrictivas que los fermiones y bosones conocidos.

En relación a las computadoras cuánticas, también se ha descubierto una nueva fase de la materia llamada Cristal de Tiempo (cristal de espacio-tiempo) que está relacionado con los conceptos de energía del vacío (punto cero) y el efecto Casimir dinámico. Los cristales de tiempo son sistemas abiertos no equilibrados donde el patrón del cristal no se repite en el espacio, sino en el tiempo. Por ejemplo, un cristal de tiempo sería como tener un copo de nieve que puede cambiar entre dos configuraciones cristalinas espontáneamente, sin usar o perder energía; a lo cual se se llama 'rompimiento de la simetría de traslación en el tiempo'. Todo esto resulta ser importante en aplicaciones de computación cuántica porque los cristales de tiempo conservan la entropía y permiten el mantenimiento de la coherencia necesaria para que las computadoras cuánticas puedan funcionar.

Otras cuasipartículas que están siendo intensamente buscadas en los experimentos con hadrones son el Odderon y el Pomeron (Pomón o Pomero, en español) que serían combinaciones de Quarks, las cuales se comportan como partículas transitorias, que pueden explicar el incremento logarítmico en la sección transversal observada en los experimentos de dispersión de alta energía; que todavía no se entiende completamente.

Apéndice: Teoría Cuántica de Campos (QFT)

La Teoría Cuántica de Campo (Quantum Field Theory o QFT, en inglés) es uno de los grandes logros de la física, de profundo interés para físicos y matemáticos. En física teórica, la teoría cuántica de campos (QFT) es un marco teórico que combina la teoría de campos clásica, la relatividad especial y la mecánica cuántica. La QFT se utiliza en física de partículas para construir modelos físicos de partículas subatómicas y en física de materia condensada para construir modelos de cuasipartículas.

En las notas siguientes vamos a explorar brevemente los avances teóricos más importantes en Teoría Cuántica de Campos (QFT) y la historia de cómo se llegaron a ellos, incluyendo: El formalismo Lagrangiano en la cuantización de los campos, la importancia del concepto del Vacío Cuántico y el Punto Cero, la magia de las técnicas de Renormalización para resolver el problema de las divergencias de las soluciones, la Electrodinámica Cuántica (QED) y la Cromodinámica Cuántica (QCD), y finalmente la Teoría de Campos de Gauge de Yang-Mills, que es una teoría de 'gauge' (calibración) basada en los Grupos de Lie de tipo SU(n).

Cuantización del Campo

Un elemento clave para entender la diferencia entre las teorías clásicas de campo (como por ejemplo la teoría del campo electromagnético de Maxwell, o la del campo gravitatorio de Einstein) y la Teoría Cuántica de Campos (Quantum Field Theory o QFT, en inglés) es el concepto de cuantización (o cuantificación) del campo.

En física teórica una 'cuantización' o 'cuantificación' es un procedimiento matemático para construir un modelo cuántico a partir de su descripción clásica. El procedimiento empieza por escribir las ecuaciones del campo clásico con el formalismo Hamiltoniano (H) o Lagrangiano (L), o a través de la Acción (S) definida como la integral en el tiempo del Lagrangiano (L), para luego aplicarles un conjunto de 'reglas de cuantización' heurísticas (que Schrödinger llamó el "hocus-pocus" de la mecánica cuántica), y como resultado los niveles de energía (que en física cuántica son discretos, en lugar de continuos como en la física clásica) ahora se van a representar a través de los autovalores del operador Hamiltoniano.

Como nota histórica, los primeros libros de texto de mecánica cuántica solían hablar de dos cuantizaciones: la primera y la segunda. Cuando se tomaban las variables del espacio de fase de las teorías clásicas como trayectorias (por ejemplo las trayectorias de la mecánica analítica) le llamaban "primera" cuantificación -- tal es el caso de la ecuación de Schrödinger (no relativista) y de la ecuación de Dirac (relativista). Pero si las variables del espacio de fase son campos o funciones del potencial del campo, le llamaban "segunda" cuantificación -- y tal es el caso de la QFT. Aunque actualmente esta distinción se considera un nombre histórico solamente, sin ningún significado físico profundo.

La interpretación física de este proceso de cuantización del campo es que las 'exitaciones' en el estado del campo cuantizado se producen por la absorción y emisión de ciertas partículas, a las cuales se les llama Quantum del campo (en singular) o Quanta del campo (en plural). Por ejemplo, el siguiente gráfico de un oscilador armónico cuántico (simulado como una esfera en un resorte) muestra los tres primeros estados de un sistema cuántico: el estado básico y dos estados exitados con 1 quantum y 2 quanta.

|

| Estados del Oscilador Cuántico: Básico, +1 Quantum, +2 Quanta |

Según se demuestra en la solución de la ecuación de Schrödinger (no relativista) para el oscilador armónico, oscilando a una frecuencia ω, el espectro de Energía del oscilador está dado por la fórmula:

En = ℏω (n + 1/2) donde n = 0,1,2 ... es el nivel de Energía del oscilador.

Donde ℏ es la Constante de Planck cruzada, es decir, dividida por 2π (ħ=h/2π).

Nótese además que el llamado 'Estado Básico' corresponde al estado 'no exitado' del oscilador con la energia más baja posible; y por eso también sería el estado más estable. Sin embargo, la energía más baja del oscilador en ese estado básico (para n=0) no coincide con el mínimo del potencial (cero en este caso). La energía más baja posible es en realidad (ℏω/2) y se denomina "energía del estado fundamental" o "energía del punto cero"; y tiene que ver con el Principio de Incertidumbre de Heisenberg entre Tiempo y Energía, y con las fluctuaciones del vacío como se explica a continuación.

Además hay que decir que la solución de la ecuación de Schrödinger es solo una solución muy aproximada cuando se trata de aplicar a los campos. La razón es que la ecuación de Schrödinger es no relativista, pero dado que las partículas que interactuán con los campos se mueven a velocidades relativistas (velocidades cercanas a la de la luz en el vacío), una teoría cuántica de campos tiene necesariamente que incluir la teoría de la relatividad restingida de Einstein. Lo cual por primera vez se hizo mediante la ecuación de Dirac, quién introdujo en la física los importantes conceptos de Partículas Virtuales, Vacío Cuántico y Energía del Punto Cero. Esto es lo que el fisico John Wheeler llamó "espuma cuántica" (quantum foam, en inglés). De esta manera, todos estos conceptos históricos ya están automáticamente incluidos en la QFT actual, incluyendo la QED y la QCD como casos particulares -- ver a continuación.

Vacío Cuántico y Energía del Punto Cero

En la teoría cuántica de campos, el vacío cuántico (o simplemente el vacío) es el estado cuántico con la menor energía posible. El término "energía del punto cero" es usado como sinónimo para el vacío de un determinado campo cuántico.

De acuerdo con la mecánica cuántica relativista (basada en la ecuación de Dirac) el vacío cuántico no está realmente vacío, sino que contiene ondas electromagnéticas fluctuantes (fotones) y partículas llamadas "virtuales" que saltan dentro y fuera de la existencia física por un pequeño intervalo de tiempo; según el Principio de Incertidumbre de Heisenberg entre Tiempo y Energía. Es decir que según las teorías cuánticas de las partículas elementales, el vacío es un objeto físico que puede tener energía y convertirse en varias partículas por un breve intervalo de tiempo.

|

| Partículas virtuales generadas por las fluctuaciones del vacío (la "espuma cuántica" como le llamó Wheeler) |

Históricamente el efecto de las fluctuaciones del vacío se observó experimentalmente en el Efecto Lamb (separación de las lineas espectrales 2S1/2 y 2P1/2 en el átomo de hidrógeno) y en el Efecto Casimir (fuerzas entre placas metálicas paralelas separadas a una distancia muy pequeña), y se interpretó físicamente como una consecuencia del Principio de Incertidumbre de Heisenberg entre Tiempo y Energía. De esta forma la primera explicación teórica de este efecto se derivó de la solución de la Ecuación de Schrödinger para el oscilador armónico, donde se demuestra que la energía del estado fundamental no es cero, sino que es igual a la mitad de la energía del quantum del escilador (ℏω/2), como ya se explicó en la sección anterior.

También los Cristales de Tiempo (cristal de espacio-tiempo), los cuales constituyen una nueva fase de la materia, están estrechamente relacionados con los conceptos de energía del vacío (punto cero) y el efecto Casimir dinámico. Los cristales de tiempo son sistemas abiertos no equilibrados donde el patrón del cristal no se repite en el espacio, sino en el tiempo, los cuales son importantes en aplicaciones de computación cuántica porque los cristales de tiempo ayudan a mantener la coherencia de los estdos cuánticos -- ver notas sobre Aplicaciones (Computadoras Cuánticas) para más información.

Actualmente además la Radiación de Hawking también se considera un efecto de las fluctuaciones del vacío en el Event Horizon de los huecos negros.

En Teoría Cuántica de Campos el vacío es el estado de energía más bajo del campo (el estado fundamental) cuando los campos se cuantifican. Por ejemplo, en la QED cuando se permite hipotéticamente que la constante de Planck se acerque a cero, entonces el vacío cuántico se convierte en vacío clásico, es decir, el vacío del electromagnetismo clásico.

En la QED la energía del punto cero debido a las fluctuaciones del vacío se puede calcular a partir de los Diagramas de Feynman, particularmente a partir del "diagrama del cuadrado" o el "diagrama del triángulo", llamadas contribuciones semiclásicas, como se muestra en el siguiente gráfico:

|

| Ejemplo de Bucle de Feynman: Triángulo |

Para más información sobre la interpretación de los Diagramas de Feynman, ver a continuación.

Diagramas de Feynman y Partículas Virtuales

QED: Electrodinámica Cuántica

QED: Electrodinámica Cuántica

Los Diagramas de Feynman son una herramienta gráfica muy útil para simplificar el cálculo de la amplitud de probabilidad ψ en física teórica de partículas, la cual requiere el uso de complejas integrales sobre un gran número de variables. Estas integrales sin embargo tienen una estructura regular, por lo cual se pueden representar gráficamente con los diagramas de Feynman (también llamados diagramas de Feynman-Dyson).

Cada diagrama de Feynman representa una posible interacción entre partículas elementales (reales o virtuales) que constituye una contribución 'perturbativa' a la amplitud de probabilidad, es decir, como un término de una serie matemática infinita; según la Teoría de Perturbaciones de la mecánica cuántica.

En cuanto al término partícula virtual, utilizado en contraposición al de partícula real en los diagramas de Feynman, es bueno aclarar que una partícula virtual es aquella que existe durante un tiempo tan corto que, debido al principio de incertidumbre de Heisenberg, no es posible medir sus propiedades de forma exacta. En otras palabras, el concepto de "partícula virtual" se utiliza para explicar las infracciones de la ley de conservación de la energía que pueden ocurrir durante un tiempo muy breve, lo cual está permitido por el principio de incertidumbre de Heisenberg entre tiempo y energía. Por eso también se dice que las partículas virtuales se producen por las 'fluctuaciones del vacío', según predice la ecuación de Dirac, las cuales se puede observar experimentalmente en el Efecto Casimir y en el Efecto Lamb (Lamb Shift) debido la interacción de los átomos con la energía del vacío (energía del Punto Cero). Además hay que tener cuidado de no confundirnos al otorgarles a las partículas virtuales ciertas propiedades (como la energía y el impulso) que solo poseen las partículas reales. Y tampoco las "partícula virtuales" deben ser confundidas con las "cuasipartículas" que resultan de las exitaciones colectivas, según se explicó anteriormente.